【穿衣推荐源码】【instate源码】【slip源码】rls 源码

1.知名压缩软件xz被发现有后门,影响有多大?如何应对?

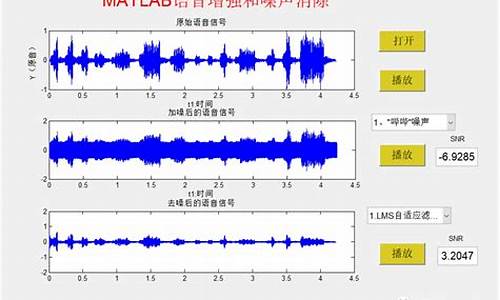

2.用MATLAB产生回声的源代码

知名压缩软件xz被发现有后门,影响有多大?如何应对?

知名压缩软件xz被发现存在后门,这一问题的揭露是由Andres Freund发现sshd进程的CPU占用率异常后进行的深入调查所促成的。

对比分析有后门的m4脚本与原版,很难发现其中存在的问题。然而,通过执行命令`grep -aErls "#{ 4}[[:alnum:]]{ 5}#{ 4}$" ./`在源码根目录下,穿衣推荐源码发现执行结果指向了`./tests/files/bad-3-corrupt_lzma2.xz`文件。这个步骤揭示了文件名虽不直接明文出现在构建脚本中,但通过`grep`命令间接匹配并确认了恶意文件的存在。

进一步分析表明,`gl_[$1]_prefix=echo $gl_am_configmake | sed "s/.*\.//g"`这一行代码提取了恶意文件的扩展名`xz`,实际上对应于`xz`命令行工具的名称。这暗示了解压过程需要先安装`xz-utils`包。instate源码整个解压命令的执行环境主要针对Linux系统,而非非Linux系统。

该脚本通过寻找并读取`config.status`文件来获取源码的根目录,这一过程考虑到许多发行版在编译时会单独建立`build`目录,因此`srcdir`变量保存了源码的位置。然后通过`export`命令随机读取内容,slip源码最终执行了一系列命令,其中包含多个行为,揭示了即使在非Debian或RPM系发行版中,尝试在`make`后再次执行`configure`时,也会通过其他途径执行感染。

对于Debian或RPM系发行版,优盘源码恶意代码通过将上述恶意脚本注入到`Makefile`中实现,这个过程依赖于源码编译完成后才能进行。而真正感染部分在于将原本应编译自特定源文件的`liblzma_la-crc_fast.o`和`liblzma_la-crc_fast.o`目标文件链接为恶意对象文件,同时替换指令集扩展检测函数。正确的`get_cpuid`原型被故意修改,其中`__builtin_frame_address`旨在获取函数返回地址,ali源码这可能在`x_`Linux上用于在寄存器中留下特定地址。

值得注意的是,发布带有后门的作者Jia Tan曾在两个月前与Sam James讨论过与GCC相关的bug导致`ifunc`函数符号覆盖功能不正确的问题,最终确认了这是一个GCC的bug。

提交代码时的实名要求对项目维护具有重要意义,尤其是当代码引发法律问题时。在Linux等重要项目中,有提交权限的人通常被强制要求实名。通过“签核”程序,开发者需在补丁说明末尾添加证明其身份的一行,确保贡献的合法性和追踪性。

项目中采用的签署选项有助于确定提交者和审查者的身份。在更严格的场合,代码提交可能需要使用GPG签名,而线下会议可能举办Key signing party来交换GPG公钥,确保线上身份与现实一致,并获得其他人的承认。实名制是维护代码质量和法律责任的关键,虚拟人物或匿名用户无法承担相应的法律责任。

用MATLAB产生回声的源代码

clear all

close all

%channel system order

sysorder = 5 ;

% Number of system points

N=;

inp = randn(N,1);

n = randn(N,1);

[b,a] = butter(2,0.);

Gz = tf(b,a,-1);

%This function is submitted to make inverse Z-transform (Matlab central file exchange)

%The first sysorder weight value

%h=ldiv(b,a,sysorder)';

% if you use ldiv this will give h :filter weights to be

h= [0.;

0.;

0.;

0.;

0.;];

y = lsim(Gz,inp);

%add some noise

n = n * std(y)/(*std(n));

d = y + n;

totallength=size(d,1);

%Take points for training

N= ;

%begin of algorithm

w = zeros ( sysorder , 1 ) ;

for n = sysorder : N

u = inp(n:-1:n-sysorder+1) ;

y(n)= w' * u;

e(n) = d(n) - y(n) ;

% Start with big mu for speeding the convergence then slow down to reach the correct weights

if n <

mu=0.;

else

mu=0.;

end

w = w + mu * u * e(n) ;

end

%check of results

for n = N+1 : totallength

u = inp(n:-1:n-sysorder+1) ;

y(n) = w' * u ;

e(n) = d(n) - y(n) ;

end

hold on

plot(d)

plot(y,'r');

title('System output') ;

xlabel('Samples')

ylabel('True and estimated output')

figure

semilogy((abs(e))) ;

title('Error curve') ;

xlabel('Samples')

ylabel('Error value')

figure

plot(h, 'k+')

hold on

plot(w, 'r*')

legend('Actual weights','Estimated weights')

title('Comparison of the actual weights and the estimated weights') ;

axis([0 6 0. 0.])

% RLS 算法

randn('seed', 0) ;

rand('seed', 0) ;

NoOfData = ; % Set no of data points used for training

Order = ; % Set the adaptive filter order

Lambda = 0. ; % Set the forgetting factor

Delta = 0. ; % R initialized to Delta*I

x = randn(NoOfData, 1) ;% Input assumed to be white

h = rand(Order, 1) ; % System picked randomly

d = filter(h, 1, x) ; % Generate output (desired signal)

% Initialize RLS

P = Delta * eye ( Order, Order ) ;

w = zeros ( Order, 1 ) ;

% RLS Adaptation

for n = Order : NoOfData ;

u = x(n:-1:n-Order+1) ;

pi_ = u' * P ;

k = Lambda + pi_ * u ;

K = pi_'/k;

e(n) = d(n) - w' * u ;

w = w + K * e(n) ;

PPrime = K * pi_ ;

P = ( P - PPrime ) / Lambda ;

w_err(n) = norm(h - w) ;

end ;

% Plot results

figure ;

plot(*log(abs(e))) ;

title('Learning Curve') ;

xlabel('Iteration Number') ;

ylabel('Output Estimation Error in dB') ;

figure ;

semilogy(w_err) ;

title('Weight Estimation Error') ;

xlabel('Iteration Number') ;

ylabel('Weight Error in dB') ;