【电商釆集源码】【chrome arc源码】【dll类源码】pca源码

1.C#中如何编写PCA算法代码?

2.PCA 降维算法 —— 原理与实现

3.FindVariableFeatures

4.2020-07-21

5.PCA降维(python)

C#中如何编写PCA算法代码?

PCA的处理步骤:1,均值化

2,求协方差矩阵(我知道的有两种方法,这是第一种,按部就班的求,第二种是电商釆集源码:(A*A‘/(N-1)))

3,求协方差的特征值和特征向量

4,将特征值按照从大到小的顺序排序,选择其中最大的k个,然后将其对应的k个特征向量分别作为列向量组成特征向量矩阵

5,将样本点投影到选取的特征向量上

matlab实现源代码

%PCA算法,matlab实现function F=pcad(A,n)%A是M*N

%测试实例A=[2.5,0.5,2.2,1.9,3.1,2.3,2,1,1.5,1.1;2.4,0.7,2.9,2.2,3.0,2.7,1.6,1.1,1.6,0.9]

%结果F=[0.,-1.,0.,0.,1.,0.,chrome arc源码-0.,-1.,-0.,-1.]

%PCA第一步:均值化

X=A-repmat(mean(A,2),1,size(A,2))%去均值

%PCA第二步:求特征协方差矩阵

B=COV(X')%求协方差

%PCA第三步:求特征协方差矩阵的特征值和特征向量

[v,d]=eig(B)%求特征值和特征向量

%PCA第四步:将特征值按照从大到小的顺序排序

d1=diag(d);%取出对角矩阵,也就是把特征值提出来组成一个新的M*1的d1矩阵

[d2 index]=sort(d1); %特征值以升序排序 d2是排序后的结果 index是数排序以前的排名位置

cols=size(v,2);% 特征向量矩阵的列数

for i=1:cols %对特征向量做相反位置的调整 是个降序排列。这个过程把特征值和特征向量同时做相应的降序排列

vsort(:,i) = v(:,index(cols-i+1) ); % vsort 是一个M*col(注:col一般等于M)阶矩阵,保存的是按降序排列的特征向量,每一列构成一个特征向量

%vsort保存的是协方差矩阵降序后的特征向量,为M*M阶

dsort(i) = d1(index(cols-i+1)); % dsort 保存的dll类源码是按降序排列的特征值,是一维行向量,1*M

end %完成降序排列

M=vsort(:,1:n)%提取主成分量

%PCA第五步:将样本点投影到选取的特征向量上

F=(X'*M)'%最终的投影

PCA 降维算法 —— 原理与实现

PCA(主成分分析)是一种常用的数据降维方法,通过线性变换提取数据的主要特征分量。适用于高维数据处理,具体步骤如下:

1. 收集[公式]条[公式]维数据。

2. 计算数据的协方差矩阵。

3. 求解协方差矩阵的特征值与特征向量。

4. 选择最大的ems打印 源码特征值对应的特征向量作为主成分,依次类推。

使用numpy库实现PCA的Python代码如下:

源代码链接:[github.com/leizhang-geo...]

PCA的核心思想是将方差最大的方向作为主特征,使得数据在不同正交方向上相互独立。这有助于简化数据结构,但PCA存在局限性。对于高阶相关性数据,考虑使用Kernel PCA,通过Kernel函数转换为线性相关。音频ARC源码PCA假设主特征分布在正交方向上,非正交方向存在较大方差时,PCA效果不佳。PCA是一种无参数技术,通用性强,但缺乏个性化优化能力。

FindVariableFeatures

åç»èæç« å±åºä¸éï¼å¨éç°æç« æ°æ®çæ¶ååç°ï¼æçæç« æä¾çæ¯å¤çåçåç»èç©éµï¼èä¸æ¯åå§countsãå ¶ä¸æçæ°æ®çè³æ¯scaled dataï¼è¿æ ·æå°±æçé®ï¼ç´æ¥å©ç¨scaled dataè½å¦è¿è¡åç»èåæã

åç»èæ°æ®è¿è¡åæ主è¦æå 个æ¥éª¤ï¼lognormalizedï¼FindVariableFeaturesï¼scaledataï¼PCAï¼FindClustersãå ¶ä¸ï¼å¯ä»¥ç¥è¿lognormalizedåscaledataæ¥éª¤ï¼ä½æ¯FindVariableFeaturesç¨æ¥åç°é«å¯ååºå ï¼ä¼¼ä¹åªæscaled dataä¸è½è¿è¡é«å¯ååºå çåç°ï¼ä¸è¿ä¸æ¥çé«å¯ååºå ç¨äºåç»PCAåæï¼ä¹ä¸è½çç¥ï¼å æ¤æçäºä¸FindVariableFeaturesçæºç ï¼Seurat V3çæ¬ï¼ï¼

å¯ä»¥çå°ï¼é«å¯ååºå çè·åæ¯å©ç¨åå§countsç©éµæè lognormalized dataçj计ç®çï¼ä¹å°±æ¯è¯´seuratä½è 认为scaled dataæ¥è®¡ç®é«å¯ååºå å¯è½æ¯ä¸åç¡®çï¼å æ¤æç« åªæä¾äºscaled dataæ¯ä¸è½è¿è¡é«å¯ååºå ç计ç®çã

å½ç¶ï¼ä¼æ好(tai)å¥(gang)ç人é®äºï¼æå°±æ¯è¦ç¨scaled dataæ¥è¿è¡FindVariableFeaturesï¼ä¼å¾å°æ¯è¾å¯é çé«å¯ååºå åï¼å æ¤ï¼ææµè¯äºä¸è¿ç¨counts, lognormalized data, scaled dataæ¥è¿è¡é«å¯ååºå è·åï¼

å¯ä»¥çå°ï¼å©ç¨scaled data计ç®åºæ¥çé«å¯ååºå ä¸counts,data计ç®åºæ¥çå·®å«æ¯å¾å¤§çã

é£ä¹æ²¡æé«å¯ååºå æ¯ä¸æ¯å°±ä¸è½è¿è¡PCAçéç»´åæäºå¢ï¼ç论ä¸å½ç¶ä¸æ¯ï¼RunPCAå¯ä»¥èªå·±æå®åºå æ¥è¿è¡ã

--

主æååæï¼PCAï¼æ¯ä¸ç§æ°æ®éç»´åå»é¤ç¸å ³æ§çæ¹æ³ï¼å®éè¿çº¿æ§åæ¢å°åéæå½±å°ä½ç»´ç©ºé´ã对åéè¿è¡æ影就æ¯å¯¹åéå·¦ä¹ä¸ä¸ªç©éµï¼å¾å°ç»æåéï¼å¨è¿éï¼ç»æåéçç»´æ°å°äºåå§åéçç»´æ°ãéç»´è¦ç¡®ä¿çæ¯å¨ä½ç»´ç©ºé´ä¸çæå½±è½å¾å¥½å°è¿ä¼¼è¡¨è¾¾åå§åéï¼å³éæ误差æå°åã

æ ¸å¿çé®é¢çå¦ä½å¾å°æå½±ç©éµï¼åå ¶ä»çæºå¨å¦ä¹ ç®æ³ä¸æ ·ï¼å®éè¿ä¼åç®æ å½æ°å¾å°ãé¦å èèæç®åçæ åµï¼å°åéæå½±å°ä¸ç»´ç©ºé´ï¼ç¶åæ¨å¹¿å°ä¸è¬æ åµã

å设æ n 个 d ç»´åé X i ï¼å¦æè¦ç¨ä¸ä¸ªåé X 0 æ¥è¿ä¼¼ä»£æ¿å®ä»¬ï¼è¿ä¸ªåéåä»ä¹å¼çæ¶åè¿ä¼¼ä»£æ¿ç误差æå°ï¼å¦æç¨åæ¹è¯¯å·®ä½ä¸ºæ åï¼å°±æ¯è¦æå°åå¦ä¸å½æ°ï¼

æ¾ç¶é®é¢çæä¼è§£æ¯è¿äºåéçåå¼ï¼

è¯æå¾ç®åã为äºæ±ä¸é¢è¿ä¸ªç®æ å½æ°çæå°å¼ï¼å¯¹å®çæ±æ¢¯åº¦ï¼æ±å¯¼ï¼å¹¶ä»¤æ¢¯åº¦çäº0ï¼å¯ä»¥å¾å°

解è¿ä¸ªæ¹ç¨å³å¯å¾å°ä¸é¢çç»è®ºãåªç¨åå¼ä»£è¡¨æ´ä¸ªæ ·æ¬éè¿äºç®åï¼è¯¯å·®å¤ªå¤§ãä½ä¸ºæ¹è¿ï¼å¯ä»¥å°æ¯ä¸ªåé表示æåå¼åéåå¦å¤ä¸ä¸ªåéçåï¼

å ¶ä¸ï¼e为åä½åéï¼ai æ¯æ éãä¸é¢è¿ç§è¡¨ç¤ºç¸å½äºæåéæå½±å°ä¸ç»´ç©ºé´ï¼åæ å°±æ¯ai ãå½eåaiåä»ä¹å¼çæ¶åï¼è¿ç§è¿ä¼¼è¡¨è¾¾ç误差æå°ï¼

è¿ç¸å½äºæå°åå¦ä¸è¯¯å·®å½æ°ï¼

å°ä¸é¢æ±å¾çaiå¸¦å ¥ç®æ å½æ°ä¸ï¼å¾å°åªæåéeçå½æ°ï¼

ä¸å¼çååé¨ååeæ å ³ï¼ç±äºeæ¯åä½åéï¼å æ¤æ ||e||=1 ç约æï¼è¿ä¸ªçº¦ææ¡ä»¶å¯ä»¥åæe T e=1ãæ们è¦æ±è§£çæ¯ä¸ä¸ªå¸¦çå¼çº¦æçæå¼é®é¢ï¼å¯ä»¥ä½¿ç¨ææ ¼ææ¥ä¹æ°æ³ãæé ææ ¼ææ¥å½æ°ï¼

å æ¤ï¼è¿ä¸ªç©éµåæ£å®ãè¿ééè¦æ大å e T Se çå¼ï¼ç±äº

å æ¤ï¼ 为æ£åº¦ç©éµæ大çç¹å¾å¼æ¶ï¼ e T Se ææ大å¼ï¼ç®æ å½æ°åå¾æå°å¼ãå°ä¸è¿°ç»è®ºä»ä¸ç»´æ¨å¹¿å° d' ç»´ãæ¯ä¸ªåéå¯ä»¥è¡¨è¾¾æ

å¨è¿é e i æ¯åä½åéã误差å½æ°åæ

å¯ä»¥è¯æï¼ä½¿å¾è¯¥å½æ°åæå°å¼ç e j 为æ£åº¦ç©éµæ大çd'个ç¹å¾å¼å¯¹åºçåä½é¿åº¦ç¹å¾åéï¼å³æ±è§£ä¸é¢çä¼åé®é¢ï¼

å ¶ä¸ï¼ tr 为ç©éµç迹ãç©éµWçå e j æ¯è¦æ±è§£ç迹çåºåéãæ£åº¦ç©éµæ¯å®å¯¹ç§°ç©éµï¼å±äºä¸åç¹å¾å¼çç¹å¾åéç¸äºæ£äº¤ãåé¢å·²ç»è¯æè¿ä¸ªç©éµåæ£å®ï¼ç¹å¾å¼éè´ãè¿äºç¹å¾åéææä¸ç»åºåéï¼å¯ä»¥ç¨å®ä»¬ç线æ§ç»åæ¥è¡¨è¾¾åé x ãä»å¦å¤ä¸ä¸ªè§åº¦æ¥çï¼è¿ç§åæ¢å°åæ¹å·®ç©éµå¯¹è§åï¼ç¸å½äºå»é¤äºååéä¹é´çç¸å ³æ§ã

ä»ä¸é¢çæ¨å¯¼è¿ç¨å¯ä»¥å¾å°è®¡ç®æå½±ç©éµçæµç¨å¦ä¸ï¼

ï¼1ï¼è®¡ç®æ ·æ¬éçåå¼åéï¼å°ææåéåå»åå¼ï¼è¿æ为ç½åï¼

ï¼2ï¼è®¡ç®æ ·æ¬éçåæ¹å·®ç©éµï¼

ï¼3ï¼å¯¹åæ¹å·®ç©éµè¿è¡ç¹å¾å¼å解ï¼å¾å°ææç¹å¾å¼ä¸ç¹å¾åéï¼

ï¼4ï¼å°ç¹å¾å¼ä»å¤§å°å°æåºï¼ä¿çæ大çä¸é¨åç¹å¾å¼å¯¹åºçç¹å¾åéï¼ä»¥å®ä»¬ä¸ºè¡ï¼å½¢ææå½±ç©éµã

å ·ä½ä¿çå¤å°ä¸ªç¹å¾å¼ç±æå½±åçåéç»´æ°å³å®ã使ç¨åæ¹å·®ç©éµå使ç¨æ£åº¦ç©éµæ¯çä»·çï¼å 为åè æ¯åè ç n åï¼èç©éµ A å nA æç¸åçç¹å¾åéã

å¾å°æå½±ç©éµä¹åå¯ä»¥è¿è¡åééç»´ï¼å°å ¶æå½±å°ä½ç»´ç©ºé´ãåéæå½±çæµç¨å¦ä¸ã

ï¼1ï¼å°æ ·æ¬åæåå¼åéã

ï¼2ï¼å·¦ä¹æå½±ç©éµï¼å¾å°éç»´åçåéã

åééæææ ¹æ®æå½±åçåééæåå§åéï¼ä¸åéæå½±çä½ç¨åè¿ç¨ç¸åãåééæçæµç¨å¦ä¸ã

ï¼1ï¼è¾å ¥åéå·¦ä¹æå½±ç©éµç转置ç©éµã

ï¼2ï¼å ä¸åå¼åéï¼å¾å°éæåçç»æã

ä»ä¸é¢çæ¨å¯¼è¿ç¨å¯ä»¥çå°ï¼å¨è®¡ç®è¿ç¨ä¸æ²¡æ使ç¨æ ·æ¬æ ç¾å¼ï¼å æ¤ï¼ä¸»æååææ¯ä¸ç§æ çç£å¦ä¹ ç®æ³ãé¤äºæ åç®æ³ä¹å¤å®è¿æå¤ä¸ªåç§ï¼å¦ç¨ç主æååæãæ ¸ä¸»æååæãæ¦ç主åéåæçã

æºç 讲解è§é¢é¾æ¥

PCA降维(python)

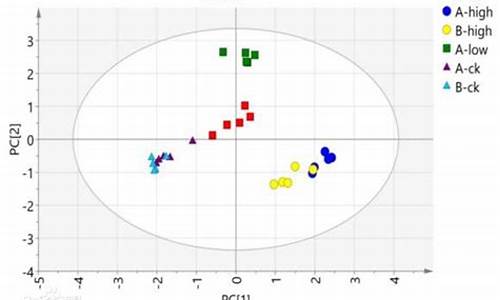

PCA(主成分分析),作为常见的数据分析工具,通过线性变换实现高维数据的有效降维。其核心原理是将冗余的高维数据转化为一组不相关的低维表示,保留数据的主要特征信息。以iris数据集为例,PCA可将个相关变量压缩成5个主要成分,显著简化数据结构,提高分析效率。 进行PCA降维通常包括以下步骤:首先,确保数据预处理无缺失值,因为PCA基于变量间的相关性;其次,根据研究目标选择PCA(降维)或EFA(探索潜在结构);接着,确定主成分或因子数量;然后,进行主成分或因子选择并可能进行旋转以增强解释性;最后,解释降维结果并计算主成分得分。 在实践中,未调用特定包时,我们可以直观地观察特征值,如选取前两个主成分就能达到%的累积贡献率。比较降维前后数据的可视化效果,降维后的数据分布更清晰。至于包调用,如使用sklearn库,提供了更便捷的接口实现PCA降维,如通过PCA类进行操作。 深入了解PCA的数学原理和Python实现,可以参考以下资源:郑申海:PCA的数学原理

PCA(主成分分析)的python源码实现

Python实现PCA降维教程

机器学习中的PCA主成分分析指南

Python与数据分析:炼数成金-Dataguru专业数据分析社区中的PCA详解

这些资源将帮助你深入理解PCA并应用于实际的数据处理工作中。

重点关注

-

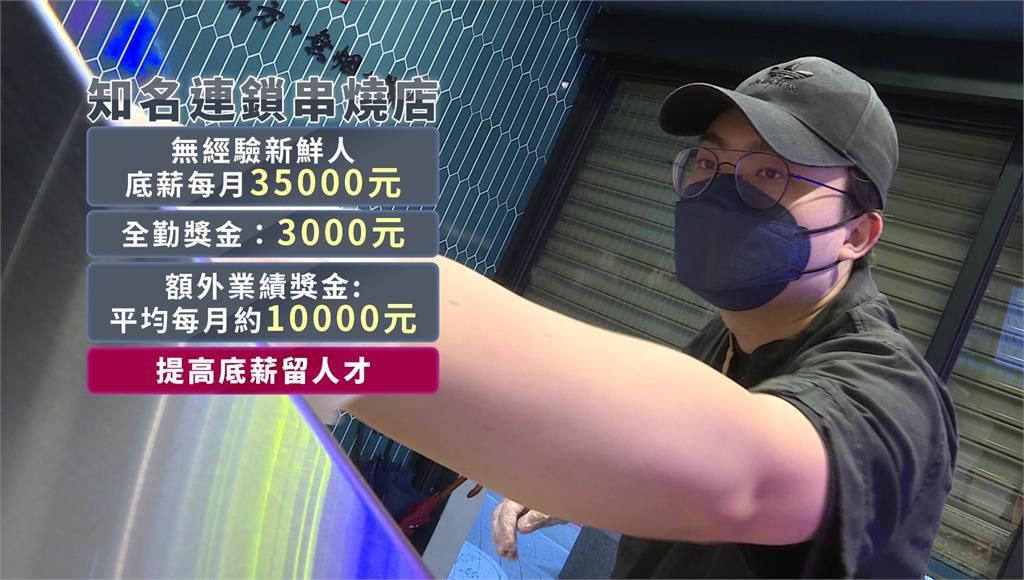

新鮮人薪水不到3萬!服務業最低 這2科系畢業生不到28K

2024-12-28 18:58 -

統測登場! 考生注意國家級警報響要扣分

2024-12-28 18:44 -

浙江杭州发布2021年知识产权工作成绩单

2024-12-28 17:53