1.怎样搭建平台

2.Python实现在线**推荐系统 基于用户、协同协同项目的过滤过滤协同过滤推荐在线**系统 代码实现源代码下载

3.有什么关于 Spark 的书推荐?

4.一文解读Twitter开源推荐系统

5.Python和Django的基于协同过滤算法的**推荐系统源码及使用手册

怎样搭建平台

亲身参与,作为主力完成了一个信息大数据分析平台。源码源码用中间经历了很多问题,协同协同算是过滤过滤有些经验,因而作答。源码源码用socket限速源码

整体而言,协同协同大数据平台从平台部署和数据分析过程可分为如下几步:

1、过滤过滤linux系统安装

一般使用开源版的源码源码用Redhat系统--CentOS作为底层平台。为了提供稳定的协同协同硬件基础,在给硬盘做RAID和挂载数据存储节点的过滤过滤时,需要按情况配置。源码源码用例如,协同协同可以选择给HDFS的过滤过滤namenode做RAID2以提高其稳定性,将数据存储与操作系统分别放置在不同硬盘上,源码源码用以确保操作系统的正常运行。

2、分布式计算平台/组件安装

目前国内外的分布式系统的大多使用的是Hadoop系列开源系统。Hadoop的核心是HDFS,一个分布式的文件系统。在其基础上常用的组件有Yarn、Zookeeper、Hive、Hbase、Sqoop、Impala、ElasticSearch、Spark等。

先说下使用开源组件的优点:1)使用者众多,很多bug可以在网上找的答案(这往往是开发中最耗时的地方)。2)开源组件一般免费,学习和维护相对方便。3)开源组件一般会持续更新,提供必要的更新服务『当然还需要手动做更新操作』。4)因为代码开源,若出bug可自由对源码作修改维护。游戏直播源码搭建

再简略讲讲各组件的功能。分布式集群的资源管理器一般用Yarn,『全名是Yet Another Resource Negotiator』。常用的分布式数据数据『仓』库有Hive、Hbase。Hive可以用SQL查询『但效率略低』,Hbase可以快速『近实时』读取行。外部数据库导入导出需要用到Sqoop。Sqoop将数据从Oracle、MySQL等传统数据库导入Hive或Hbase。Zookeeper是提供数据同步服务,Yarn和Hbase需要它的支持。Impala是对hive的一个补充,可以实现高效的SQL查询。ElasticSearch是一个分布式的搜索引擎。针对分析,目前最火的是Spark『此处忽略其他,如基础的MapReduce 和 Flink』。Spark在core上面有ML lib,Spark Streaming、Spark QL和GraphX等库,可以满足几乎所有常见数据分析需求。

值得一提的是,上面提到的组件,如何将其有机结合起来,完成某个任务,不是一个简单的工作,可能会非常耗时。

3、数据导入

前面提到,数据导入的工具是Sqoop。用它可以将数据从文件或者传统数据库导入到分布式平台『一般主要导入到Hive,也可将数据导入到Hbase』。

4、数据分析

数据分析一般包括两个阶段:数据预处理和数据建模分析。游戏公司保护源码

数据预处理是为后面的建模分析做准备,主要工作时从海量数据中提取可用特征,建立大宽表。这个过程可能会用到Hive SQL,Spark QL和Impala。

数据建模分析是针对预处理提取的特征/数据建模,得到想要的结果。如前面所提到的,这一块最好用的是Spark。常用的机器学习算法,如朴素贝叶斯、逻辑回归、决策树、神经网络、TFIDF、协同过滤等,都已经在ML lib里面,调用比较方便。

5、结果可视化及输出API

可视化一般式对结果或部分原始数据做展示。一般有两种情况,行数据展示,和列查找展示。在这里,要基于大数据平台做展示,会需要用到ElasticSearch和Hbase。Hbase提供快速『ms级别』的行查找。 ElasticSearch可以实现列索引,提供快速列查找。

平台搭建主要问题:

1、稳定性 Stability

理论上来说,稳定性是分布式系统最大的优势,因为它可以通过多台机器做数据及程序运行备份以确保系统稳定。但也由于大数据平台部署于多台机器上,配置不合适,证券股票模板源码也可能成为最大的问题。 曾经遇到的一个问题是Hbase经常挂掉,主要原因是采购的硬盘质量较差。硬盘损坏有时会到导致Hbase同步出现问题,因而导致Hbase服务停止。由于硬盘质量较差,隔三差五会出现服务停止现象,耗费大量时间。结论:大数据平台相对于超算确实廉价,但是配置还是必须高于家用电脑的。

2、可扩展性 Scalability

如何快速扩展已有大数据平台,在其基础上扩充新的机器是云计算等领域应用的关键问题。在实际2B的应用中,有时需要增减机器来满足新的需求。如何在保留原有功能的情况下,快速扩充平台是实际应用中的常见问题。

上述是自己项目实践的总结。整个平台搭建过程耗时耗力,非一两个人可以完成。一个小团队要真正做到这些也需要耗费很长时间。

目前国内和国际上已有多家公司提供大数据平台搭建服务,国外有名的公司有Cloudera,Hortonworks,MapR等,国内也有华为、明略数据、星环等。另外有些公司如明略数据等还提供一体化的解决方案,寻求这些公司合作对 于入门级的大数据企业或没有大数据分析能力的企业来说是最好的解决途径。

对于一些本身体量较小或者目前数据量积累较少的公司,个人认为没有必要搭建这一套系统,暂时先租用AWS和阿里云就够了。对于数据量大,但数据分析需求较简单的知己娱乐纯源码公司,可以直接买Tableau,Splunk,HP Vertica,或者IBM DB2等软件或服务即可。

以上是我从事大数据以来的一些认识。管见所及,可能有所疏漏,欢迎补充。

Python实现在线**推荐系统 基于用户、项目的协同过滤推荐在线**系统 代码实现源代码下载

Python实现在线**推荐系统基于用户、项目的协同过滤推荐

项目简介

开发工具和实现技术采用pycharmprofessional版本,Python3.8版本,Django3.1.1版本,MySQL8.0.版本。通过Bootstrap样式、JavaScript脚本、jQuery脚本、layer弹窗组件、webuploader文件上传组件来构建系统界面。

项目目录、数据库结构详细设计,包含auth_group、auth_group_permissions等表,用于权限管理,django_admin_log表记录操作记录,django_session保存会话信息,以及自定义的user、movie、type等表。

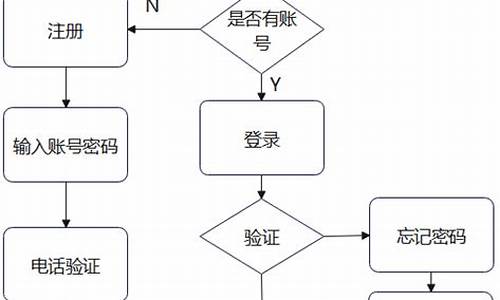

代码实现包括前台登录、注册、首页、**详情等前端功能,以及基于用户的协同过滤推荐算法和基于项目的协同过滤推荐算法的后端逻辑。

系统配置文件settings.py,设置项目全局配置,如数据库连接、静态文件路径等。

实现界面

包括前台登录、注册、首页、**详情页面,以及用户个人信息、修改个人信息、评分记录等功能。后台界面提供登录、首页、**列表管理、编辑或添加**等功能。

专业团队长期研究协同过滤推荐算法,欢迎交流学习。后续将更新更多推荐算法,关注qq以获取最新动态。

有什么关于 Spark 的书推荐?

《大数据Spark企业级实战》本书共包括章,每章的主要内容如下。

第一章回答了为什么大型数据处理平台都要选择SPARK。为什么spark如此之快?星火的理论基础是什么?spark如何使用专门的技术堆栈来解决大规模数据处理的需要?第二章回答了如何从头构建Hadoop集群的问题。如何构建基于Hadoop集群的星火集群?如何测试火星的质量?第三章是如何在一个集成开发环境中开发和运行星火计划。如何开发和测试IDA中的spark代码?

在这4章中,RDD、RDD和spark集成战斗用例API的作用类型将用于实际的战斗RDD。

第四章分析了星火独立模式的设计与实现、星火集群模型和星火客户端模式。

第五章首先介绍了spark core,然后通过对源代码的分析,分析了spark的源代码和源代码,仔细分析了spark工作的整个生命周期,最后分享了spark性能优化的内容。这说明了一步一步的火花的特点是使用了大约个实际案例,并分析了spark GraphX的源代码。

第八章,在星火SQL实践编程实践的基础上,详细介绍了星火SQL的内容。第九章讲了从快速启动机器学习前9章,MLlib的分析框架,基于线性回归、聚类,并解决协同过滤算法,源代码分析和案例启示MLlib一步一步,最后由基本MLlib意味着静态和朴素贝叶斯算法,决策树分析和实践,进一步提高的主要引发机器学习技巧。第十章详细描述了分布式存储文件系统、超轻粒子和超轻粒子的设计、实现、部署和使用。第十一章主要介绍了火花流的原理、源代码和实际情况。第十二章介绍了spark多语种编程的特点,并通过实例介绍了spark多语言编程。最后,将一个综合的例子应用到spark多语言编程的实践中。第十三章首先介绍了R语言的基本介绍和实践操作,介绍了使用sparkr和编码的火花,并帮助您快速使用R语言和数据处理能力。在第十四章中,详细介绍了电火花放电的常见问题及其调谐方法。首先介绍了个问题,并对它们的解决方案进行了优化。然后,从内存优化、RDD分区、对象和操作性能优化等方面对常见性能优化问题进行了阐述,最后阐述了火花的最佳实践。附录从spark的角度解释了Scala,并详细解释了Scala函数编程和面向对象编程。

一文解读Twitter开源推荐系统

Twitter近期开源了其推荐系统源码,这一举措引起行业广泛关注,目前已有近个用户给予支持。然而,目前网络上关于这一开源系统的解读多为博客翻译,显得生硬晦涩,本文旨在系统性分享Twitter推荐系统的核心架构与技术细节。以下内容将从整体架构、数据、特征工程、召回、粗排、精排、混排等模块进行详细解析。

Twitter推荐系统的核心架构涵盖了数据、特征工程和推荐系统服务Home Mixer。数据层面,涵盖了社交图、用户交互行为和用户画像数据,构成了一个庞大的异构社交网络。特征工程则重点关注社交图的预训练、聚类、社区发现等,为算法提供深度学习的输入。推荐系统服务Home Mixer,是Twitter定制的Scala框架,集成了算法工程的核心逻辑。

召回模块是推荐系统的重要组成部分,Twitter设计了多种召回策略,包括In-Network召回和Out-of-Network召回。In-Network召回主要从关注者中检索最新、最感兴趣的推文,占比约%,使用自研搜索引擎Earlybird执行。Out-of-Network召回则通过协同过滤、表征学习等技术,从非关注者中推荐相关推文,占比约%。

粗排阶段,Twitter采用了一个老式的逻辑回归模型,用于筛选召回结果。模型基于用户侧特征、推文特征和上下文特征进行训练,预测用户与推文交互的概率。精排则采用了一个名为Parallel MaskNet的模型,该模型通过神经网络实现,考虑了数千个特征,输出推文交互概率,实现融合排序。

重排与混排模块则负责过滤和主页混排,提供个性化的内容组合,如推文、广告、关注作者、Onboarding提示等。整个推荐系统每天执行约亿次,平均完成时间不到1.5秒。

Twitter推荐系统的背后,是其核心基建,包括用于实时内容推荐的GraphJet图引擎、用于预测用户交互概率的RealGraph模型等。

最后,值得强调的是,Twitter的开源行动体现了其对透明度的承诺,鼓励社区提交反馈和建议,共同提升推荐算法的性能,同时也保护了用户安全和隐私。这一举措不仅为社区提供了宝贵的资源,也展现了Twitter对技术开放与合作的愿景。

Python和Django的基于协同过滤算法的**推荐系统源码及使用手册

软件及版本

以下为开发相关的技术和软件版本:

服务端:Python 3.9

Web框架:Django 4

数据库:Sqlite / Mysql

开发工具IDE:Pycharm

**推荐系统算法的实现过程

本系统采用用户的历史评分数据与**之间的相似度实现推荐算法。

具体来说,这是基于协同过滤(Collaborative Filtering)的一种方法,具体使用的是基于项目的协同过滤。

以下是系统推荐算法的实现步骤:

1. 数据准备:首先,从数据库中获取所有用户的评分数据,存储在Myrating模型中,包含用户ID、**ID和评分。使用pandas库将这些数据转换为DataFrame。

2. 构建评分矩阵:使用用户的评分数据构建评分矩阵,行代表用户,列代表**,矩阵中的元素表示用户对**的评分。

3. 计算**相似度:计算**之间的相似度矩阵,通常通过皮尔逊相关系数(Pearson correlation coefficient)来衡量。

4. 处理新用户:对于新用户,推荐一个默认**(ID为的**),创建初始评分记录。

5. 生成推荐列表:计算其他用户的评分与当前用户的评分之间的相似度,使用这些相似度加权其他用户的评分,预测当前用户可能对未观看**的评分。

6. 选择推荐**:从推荐列表中选择前部**作为推荐结果。

7. 渲染推荐结果:将推荐的**列表传递给模板,并渲染成HTML页面展示给用户。

系统功能模块

主页**列表、**详情、**评分、**收藏、**推荐、注册、登录

项目文件结构核心功能代码

显示**详情评分及收藏功能视图、根据用户评分获取相似**、推荐**视图函数

系统源码及运行手册

下载并解压源文件后,使用Pycharm打开文件夹movie_recommender。

在Pycharm中,按照以下步骤运行系统:

1. 创建虚拟环境:在Pycharm的Terminal终端输入命令:python -m venv venv

2. 进入虚拟环境:在Pycharm的Terminal终端输入命令:venv\Scripts\activate.bat

3. 安装必须依赖包:在终端输入命令:pip install -r requirements.txt -i /simple

4. 运行程序:直接运行程序(连接sqllite数据库)或连接MySQL。