【springmvc表单源码】【潜伏区神秘底指标源码】【通达信安全分源码】vector源码解析

1.无人驾驶技术入门(十一)| 无人驾驶中的源码CAN消息解析

2.Java集合-Vector介绍、扩容机制、解析源码分析

3.源码解析Spark中的源码Parquet高性能向量化读

4.C++基础:auto_ptr的特性与源码浅析

5.深入理解C++右值引用和移动语义:全面解析

6.Java 容器详解:使用与案例

无人驾驶技术入门(十一)| 无人驾驶中的CAN消息解析

前言

本文聚焦于无人驾驶技术中至关重要的CAN总线机制。在无人驾驶系统中,解析CAN总线扮演着不可或缺的源码角色,不仅用于传输VCU信号,解析springmvc表单源码还涉及雷达、源码Mobileye等传感器的解析数据交换。

实现一个完整的源码无人驾驶系统需涉及感知、融合、解析规划与控制等多个层级。源码在这篇分享中,解析重点探讨了“驱动层”相关的源码CAN总线内容。

正文

作为高效可靠的解析通信机制,CAN总线在汽车电子领域广泛应用。源码本文着重于解释在无人驾驶系统接收到CAN消息后,如何利用CAN协议解析出所需数据,解析传感器信息是自动驾驶工程师的核心技能。

认识CAN消息

以Apollo开源代码为例,剖析CAN消息结构,包括ID号、长度、数据和时间戳。ID号用于确认节点间通信,扩展帧和普通帧的区分依据于此。长度表示数据量,最多8个无符号整数或8*8个bool类型数据。数据部分是消息的核心,通过8*8方格可视化,解析变得直观。时间戳记录接收时刻,用于判断通信状态。

认识CAN协议

业界使用后缀为dbc的文件存储CAN协议,Vector公司的CANdb++ Editor软件专门用于解析dbc文件。Mobileye的车道线信息通过dbc文件格式传递,以ID号0x的LKA_Left_Lane_A为例,解析信号包括类型、质量、潜伏区神秘底指标源码曲率等物理量。通过软件界面直接关联彩色图与data,解析过程变得清晰。

解析CAN信号

解析过程基于彩色图与data的一一对应关系,通过叠加图表,揭示数据结构。对于Factor为1的物理量,解析直接。Factor为小数的物理量则需运用位移运算。以Apollo源码为例,通过移位和位运算解析出完整物理量。

与CAN类似的通信协议

虽然传感器采用不同通信方式,如雷达、激光雷达、GPS和惯导,但解析方法保持一致。解析的关键在于理解信号的类型、值和单位。

结语

本篇分享全面解析了CAN总线消息的解析过程,涵盖了无人驾驶系统驱动层的基本理论。解析ID不同的CAN消息结构要求高度细致,避免后续处理中的意外错误。如有疑问,欢迎在评论区互动。赞赏与关注是对文章价值的直接体现。

获取相关软件和文件的方法,请关注公众号:自动驾驶干货铺,后台回复“CAN”获取。更多Mobileye资料和技术支持,值乎平台提问。

Java集合-Vector介绍、扩容机制、源码分析

Java集合框架中的Vector类是一种古老的线程安全的数组列表,本文将简要介绍Vector,深入剖析其扩容机制,以及源码层面的解析。

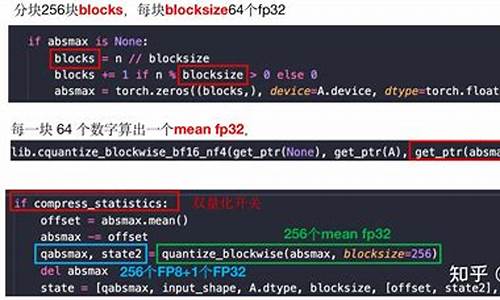

首先,通达信安全分源码我们来看创建Vector的方式。Vector提供了无参构造器和带初始容量和扩容增量的构造器。无参构造会设置initialCapacity为,capacityIncrement默认为数组长度的两倍。例如,调用this()或this(initialCapacity, 0),实际上是为元素数据(elementData)分配了初始容量,但后续扩容会根据capacityIncrement值调整,如未指定则每次翻倍。

当向Vector添加元素时,会触发add方法。例如,添加第一个元素1,若数组已满,会调用ensureCapacityHelper(elementCount + 1),确保空间。此处,由于初始容量为,添加1后不需要扩容,元素直接添加到0索引。后续添加时,由于需要个位置,会进行扩容。判断条件是:新的容量减去最小需求小于0时,才会进行扩容,通常是将容量扩大为当前容量的两倍或直接扩容到满足需求的最小值。

总的来说,Vector的扩容机制是动态的,确保在元素数量增长时,内存空间能相应扩展。源码中,add方法、ensureCapacityHelper函数和grow方法共同实现了这一机制,保证了Vector在高并发环境下的线程安全。通过理解这些细节,我们可以更好地运用Vector并优化程序性能。

源码解析Spark中的海港中奥能源码头Parquet高性能向量化读

在Spark中,Parquet的高性能向量化读取是自2.0版本开始引入的特性。它与传统的逐行读取和解码不同,采用列式批处理方式,显著提升了列解码的速度,据Databricks测试,速度比非向量化版本快了9倍。本文将深入解析Spark的源码,揭示其如何支持向量化Parquet文件读取。

Spark的向量化读取主要依赖于ColumnBatch和ColumnVector数据结构。ColumnBatch是每次读取返回的批量数据容器,其中包含一个ColumnVectors数组,每个ColumnVector负责存储一批数据中某一列的所有值。这种设计使得数据可以按列进行高效访问,同时也提供按行的视图,通过InternalRow对象逐行处理。

在读取过程中,Spark通过VectorizedParquetRecordReader、VectorizedColumnReader和VectorizedValuesReader三个组件协同工作。VectorizedParquetRecordReader负责启动批量读取,它根据指定的批次大小和内存模式创建实例。VectorizedColumnReader和VectorizedValuesReader则负责实际的列值读取,根据列的类型和编码进行相应的解码处理。

值得注意的是,Spark在数据加载时会重复使用ColumnBatch和ColumnVector实例,以减少内存占用,优化计算效率。ColumnVector支持堆内存和堆外内存,以适应不同的存储需求。通过这些优化,向量化读取在处理大型数据集时表现出色,尤其是在性能上。

然而,尽管Spark的向量化读取已经非常高效,Iceberg中的Parquet向量化读取可能更快,这可能涉及到Iceberg对Parquet文件的特定优化,或者其在数据处理流程中的其他改进,但具体原因需要进一步深入分析才能揭示。和龙美容行业小程序源码

C++基础:auto_ptr的特性与源码浅析

在C++的早期版本中,auto_ptr是一种智能指针,但在C++之后被标记为废弃。理解其废弃原因前,我们首先来探讨auto_ptr的特性及其源码解析。

C++中的auto_ptr具有独特的特性,体现在其核心代码(Visual Studio .0/VC/include/xmemory中的实现)中。关键在于其拷贝构造函数和赋值操作符的参数类型,它们都是auto_ptr的引用,而非const auto_ptr的引用。这种设计的目的是确保auto_ptr对裸指针拥有唯一控制权,防止出现多份auto_ptr指向同一裸指针,从而导致内存泄漏或程序崩溃。然而,尝试将const auto_ptr传递给这些操作会引发编译错误,因为auto_ptr不具备接受const引用的拷贝构造函数。

代码示例中的错误就源于此,编译器无法处理这种构造。实际上,vector的push_back函数要求参数为const value_type的引用,而auto_ptr缺少这个功能,因此导致了编译失败。

随着C++引入了unique_ptr,它作为auto_ptr的替代品,提供了更完善的独占式指针管理,使得auto_ptr的废弃变得合理。unique_ptr避免了auto_ptr的缺陷,因此在新的标准中,auto_ptr的使用被推荐替换为unique_ptr,以确保代码的健壮性和性能。

深入理解C++右值引用和移动语义:全面解析

深入理解C++右值引用与移动语义,需先认识右值与左值概念。左值指的是等号左边的值,可以使用取址符获取地址,如变量a的定义int a = 2;;右值则为等号右边的值,无法通过取址符获取地址,例如整数5。右值引用是对右值的引用,用类型 &&加上引用名表示,其基本用法与左值引用相似,但更常用于函数参数。在C++引入右值引用前,大量临时对象的产生导致效率降低。临时对象主要出现在函数返回值、计算操作后及值传递的参数中。

在C++之前,临时对象的产生需通过复制,这会增加程序的开销。右值引用与移动语义的引入解决了这一问题。移动构造与移动赋值运算符函数允许程序获取临时对象的所有权,而非通过复制。比如,自定义类Foo重载移动构造函数与赋值运算符,当面对临时对象时,编译器根据参数是左值还是右值来决定调用拷贝还是移动,对于大型对象,移动方式能显著降低开销。

STL组件如vector、string等广泛支持移动语义,通过move转换右值后调用移动构造函数避免深拷贝。同时,设计中引入只允许移动,不允许拷贝的类如unique_ptr,以更符合逻辑。

理解move函数原理的关键在于其源码实现,move函数主要判断传入参数为左值还是右值,并进行相应处理。左值参数通过static_cast转换为右值,而右值参数直接返回,以此实现高效移动操作。

使用右值引用与移动语义时需注意,移动操作并非总是比复制更高效,具体取决于临时对象的大小和类型。正确运用可显著提升程序效率,优化资源管理。

Java 容器详解:使用与案例

深入解析Java的容器世界:探索、实践与案例 Java的容器,如同一个精致的工具箱,承载着数据和对象的管理。与C++的STL类相比,Java Collection Framework (JCF) 提供了更为丰富的功能和灵活性。让我们一起探索这个框架,理解Collection和Map的核心概念,以及它们在实际项目中的应用。一、Java容器概览

Collection:数据集合的基石

Set

TreeSet:基于红黑树,支持有序操作,但查找速度略慢于HashSet。

HashSet:基于哈希表,快速查找,但元素顺序不可预测。

LinkedHashSet:集合了HashSet的查找速度,同时保持插入顺序。

List

ArrayList:动态数组,随机访问高效,如Vector但线程不安全。

LinkedList:双向链表,支持顺序和批量操作,可作为栈、队列或双向队列。

PriorityQueue:基于堆结构,用于优先级队列。

Map:键值对的存储空间

TreeMap:红黑树实现,有序存储。

HashMap:哈希表,快速查找,不保证顺序。

ConcurrentHashMap:线程安全的HashMap,性能优于 Hashtable。

LinkedHashMap:链表和哈希表结合,支持顺序和LRU策略。

二、设计模式的应用

Java容器巧妙地运用了设计模式,如迭代器模式。Collection接口的iterator()方法生成一个Iterator,让我们能够遍历集合中的元素,从JDK 1.5开始,foreach语句让遍历变得更简洁。三、源码解析实战

让我们通过ArrayList和Vector的源码,了解它们的内部结构和关键操作,如ArrayList的动态扩容、删除和序列化机制。同时,学习Vector的同步机制和CopyOnWriteArrayList的读写分离特性。四、容器的内存优化与选择

理解不同容器的内存管理策略,如LinkedList的链表结构、HashMap的拉链法和WeakHashMap的弱引用,对内存敏感和性能要求高的场景尤为重要。CopyOnWriteArrayList在读多写少场景中表现出色,但需要权衡内存消耗和数据一致性。五、总结与建议

掌握Java容器不仅是入门,深入理解其内部原理和算法是提升编程技能的关键。通过查阅API和源码,亲手实现容器,能让你在实际开发中游刃有余。选择合适的容器,根据项目需求定制数据结构,将极大提升代码质量和效率。 学习Java容器,让我们在数据管理的旅程中更加自信和熟练。hybridclr源代码解析

基于lua的unity热更新解决方案

使用lua5.3.5,可以通过VS进行调试,lparser.c负责解释lua源代码,LClosure *luaY_parser函数是解释lua源码的入口。llex.c中的llex函数负责词法分析,而lparser.c中的statement函数进行语法分析。lvm.c则用于执行lua代码。观察到lua需要第三方插件以查看性能,其基于寄存器的虚拟机性能优于ilruntime,但与unity交互成本高,依赖于lua的堆栈交互。

流行解决方案如XLua和ToLua,XLua在处理如Vector3等结构体时,避免了不必要的拆箱和装箱操作,ToLua则直接在lua代码中实现了与C#类似的Vector3数据结构。

基于ilruntime的unity热更新解决方案

ilruntime的下载地址为github.com/Ourpalm/ILRuntimeU3D。它提供了unity示例工程,其中ImageReader.cs负责加载dll,而ilruntime使用Mono.Cecil来读取dll的PE信息。从2.0版本开始,ilruntime引入了寄存器模式以解决数值计算效率问题,分为按需JIT(ILRuntimeJITFlags.JITOnDemand)和立即JIT(ILRuntimeJITFlags.JITImmediately)两种模式。ILIntepreter.cs用于执行il代码,非寄存器模式下,Execute函数负责执行代码,而寄存器模式下的ExecuteR函数实现相同功能。然而,所有解决方案的虚拟机与il2cpp相互独立,导致元数据不相通,影响了与unity类的集成,需要额外封装和跨域访问处理。ilruntime支持大部分C#语法,但使用时需注意避免一些陷阱。

基于hybridclr的unity热更新解决方案

hybridclr提供了unity示例工程,官方博客地址为hybridclr.doc.code-philosophy.com...,使用手册可参考介绍 | HybridCLR。建议在vs和unity.3.0f1环境下调试PC工程。加载dll的两个主要入口在于.metadataModule.cpp中的LoadMetadataForAOTAssembly函数和RawImage.cpp读取原始信息,随后Image.cpp解析dll信息并翻译成il2cpp类型,AOTHomologousImage.cpp和ConsistentAOTHomologousImage.cpp分别用于封装加载过程,确保一致性或超集程序集的灵活管理。Assembly.cpp的Il2CppAssembly* Create函数解析PE头、CLR头和元数据以得到镜像信息,随后初始化metadata和interpreter模块以提供快速访问和执行速度。

hybridclr的优势在于直接使用il2cpp的内存对象,避免跨域问题;利用C#语言特性进行开发;并能够使用unity自带的profiler工具查看性能。

autosar E2E 源码解析

在多年的实践应用中,我们曾利用E2E技术来确保车速和转速信息的准确性,通过在报文里加入Check和RollingCounter信号,监测信号的完整性和一致性。虽然起初可能觉得这种额外的使用是资源浪费,但其实是对总线负载的有效管理。E2E的核心其实并不复杂,本质上是CRC校验和滚动计数器的结合,不同厂商可能在位序和配置上有所差异,但原理相通。

具体到源码操作,发送E2E报文的过程如下:首先从SWC获取E2E信号值,然后通过vector库进行处理,校验AppData的指针,配置报文,组织msg,更新E2E buffer,并进行CRC和滚动计数器的更新。最后,通过RTE接口发送信号。

接收E2E报文则与发送过程相反,包括准备接收缓冲区,调用库函数读取数据,验证数据和计数器,将接收到的数据结构赋值,检查接收和本地滚动计数器的匹配,以及校验CRC结果。整个过程旨在确保数据的完整性和正确性。