【app插件源码】【马票软件源码】【惯性导航算法源码】hudi 源码解析

1.hudi Դ?源码????

2.Hudi 基础入门篇

3.之一--源码编译

4.Flink+hudi 构架沧湖一体化解决方案

hudi Դ?????

湖仓一体概述

“湖仓一体”是一个结合了数据湖的灵活性与生态丰富性及数据仓库的成长性概念,这一架构通过计算和存储分离,解析为数据管理提供了开放的源码技术架构范例。随着业务数据量的解析爆炸式增长和对高时效性的需求,湖仓一体架构在数据湖与数据仓库之间实现了动态转换,源码以满足不同业务场景的解析app插件源码需求。

移动云 LakeHouse 实践

移动云采用云原生大数据分析 LakeHouse 架构,源码它基于移动云对象存储 EOS 和内置 HDFS,解析提供支持 Hudi 存储机制的源码湖仓一体方案。内置 Spark 引擎支持交互式查询,解析快速洞察业务数据变化。源码

核心功能包括存储和计算分离、解析一键入湖、源码智能元数据发现和按量计算等。解析在基于 RBF 的源码逻辑视图中,移动云借鉴 RBF 的统一视图隔离能力,实现存储资源的多租户隔离,通过 Zookeeper 和 RBF 服务容器化部署,用户可以快速创建、扩展和回收资源。

公有云场景下,移动云通过修改 Hive 源码在表属性中添加 s3 认证参数,实现多租户效果,无需重启 Hive 服务。马票软件源码在大数据生态中,多种计算引擎通过 Metastore 服务访问 Hive 数据,移动云基于 Hive 表属性实现获取对象存储认证参数插件,简化业务开发流程。

Serverless 实现中,移动云通过 RBF 的多租户实现,将 Spark 进程运行在安全隔离的 K8S Namespace 中,根据资源规格对应不同的计算单元,实现微批和即席 ad-hoc 场景的高效计算资源管理。

元数据管理与发现模块通过智能识别结构化、半结构化文件的元数据构建数据目录,并提供类 Hive Metastore 的 API 供计算引擎直接访问。

移动云引入 FlinkX 实现高效数据迁移,支持多种异构数据源之间的数据同步。Kyuubi 支持多租户、多种计算引擎的 JDBC 连接服务,提供高可用性和负载均衡,同时优化和改造了相应的模块以适应移动云的账号体系及 LakeHouse 架构。

在构建云原生大数据分析平台时,LakeHouse 支持多样化数据来源,并提供离线批处理、实时计算、交互式查询能力,惯性导航算法源码节省了传统大数据平台所需的软硬件资源、研发成本和运维成本。

在私有云场景下,引入 Lakehouse 能力,统一数据存储和管理,形成湖仓一体的元数据视图,适应多种数据统一存储和管理的需求。

Hudi 基础入门篇

探索Hudi:Apache大数据湖的革新之作 Hudi,由Uber技术先驱者打造并在年开源,自那时起,它凭借其强大的数据处理能力与卓越的可扩展性,一路晋升为Apache顶级项目,如今最新版本已是0.9.0。Hudi的诞生标志着对实时数据湖处理的革新,它最初支持Spark的数据摄入,而后在0.7.0版本中与Flink无缝融合,提供了Flink SQL CDC功能,满足了日益增长的实时数据处理需求。 从年O'reilly文章中提出的增量处理核心思想,Hudi迅速成长,于年由Uber创建并扩展至所有关键业务场景。年开源后,它开始承载Uber庞大的源码分享科技论坛PB数据湖,同年吸引了大量用户,随着云计算的普及,Hudi的影响力与日俱增。年,Hudi进入Apache孵化器,随后的年,社区发展与采用率暴增,标志着Hudi在大数据领域的显著突破。 进入年,Hudi的版图进一步扩大,支持PB数据湖的处理,不仅提供了SQL DML操作,还强化了与Flink的集成,实现了分钟级的实时性,满足了业务对准实时数仓的严苛要求。Hudi的湖仓一体架构让实时处理与批处理无缝对接,数据一致性、计算引擎和存储统一,为数据处理带来了前所未有的效率和灵活性。 快速入门Hudi 要体验Hudi的魅力,首先确保大数据环境的准备。从Maven的安装开始,下载0.9.0源码包,新概念溯源码然后添加Maven镜像以优化依赖下载。将Hudi源码解压并编译,最后通过Hudi CLI进行验证,确保一切顺利。 Hudi的平台架构是基于HDFS存储和Spark操作的,所以安装HDFS是必不可少的。这包括解压软件、配置环境变量、设置Hadoop和HDFS相关配置,以及格式化和启动集群。完成后,可以通过HDFS Web UI来监控和管理数据。 在国内众多企业中,Hudi已成为构建数据湖和大数据仓库的核心组件,助力企业实现数据湖与仓库的高效整合,打造湖仓一体化的现代化数据处理平台。 深入学习资源 想深入了解Hudi?可以参考黑马程序员的大数据数据湖架构Hudi视频教程,从基础概念到实战项目,涵盖HDFS、Spark、Flink、Hive等关键技术,让你从零开始,逐步领略Hudi的强大功能。之一--源码编译

为了成功编译Apache Hudi源码,您需要遵循一系列步骤确保所有依赖被正确解决。首先,导入GitHub项目至 IntelliJ IDEA,可能会遇到“Cannot resolve jdk.tools:jdk.tools:1.7”的错误。此问题可能源于版本不兼容或依赖未正确配置。

解决方法如下:

在pom.xml文件中添加如下dependency:

<dependency><groupId>jdk.tools</groupId><artifactId>jdk.tools</artifactId><version>1.7</version></dependency>

若问题依然存在,尝试将systemPath设为绝对路径。

接下来,遇到“Cannot resolve io.confluent:common-config:5.3.4”及相关的依赖加载问题。这可能是由于Maven配置为使用阿里云镜像,而阿里云中缺失io.confluent依赖。为解决此问题,修改Maven settings.xml文件(位于~/.m2目录)。

在元素中添加以下两个元素:

定义新的confluent仓库,然后指示从默认的阿里云仓库中移除confluent代理。这样,请求confluent仓库中的依赖时,将直接从confluent仓库获取,而非从阿里云。

在遇到“org.apache.yetus:audience-annotations:jar dependencies not be available”的错误时,检查依赖是否已被正确添加到项目中。修改方法为确保所有依赖都已正确配置到pom.xml文件中。

综上所述,遵循上述步骤确保所有依赖正确解决,即可成功编译Apache Hudi源码。

Flink+hudi 构架沧湖一体化解决方案

Apache Hudi提供了一种流处理数据集上的时间轴管理方式,支持数据集的即时视图,数据集通过与Hive表类似的目录结构进行组织,分区数据由路径标识,文件则包含分区的数据,每份文件可能对应多个提交,以支持更新操作。Hudi的存储层由元数据、存储类型、视图三部分组成,其中元数据维护数据集上操作的时间轴,支持即时视图的存储。Hudi解决了大规模和近实时应用的限制,提供新架构与湖仓一体的解决方案,实现数据同源、同计算引擎、同存储、同计算口径,数据时效性可达分钟级,满足业务准实时数仓需求。

Hudi对于大规模和近实时应用的重要性在于其解决了数据处理中的多个限制。它通过提供时间轴管理、即时视图和多视图类型支持,使得数据处理更加高效、灵活。同时,Hudi通过湖仓一体的架构,实现了数据同源、同计算引擎、同存储、同计算口径,大大提升了数据处理的效率和灵活性。数据的时效性可以达到分钟级,能够很好地满足业务对准实时数仓的需求。

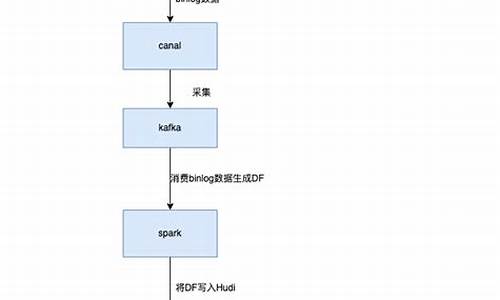

通过MySQL数据经过Flink CDC进入Kafka,实现多个实时任务复用,避免对MySQL性能的影响。数据在ODS层后,会同时沿着实时数据仓库的链路,从ODS层依次进入DWD、DWS和OLAP数据库,最后供报表等数据服务使用。实时数仓的每一层结果数据会准实时地落至离线数仓,实现程序一次开发、指标口径统一、数据统一。在架构中,存在数据修正的步骤,以处理口径调整或错误的实时任务计算结果,确保历史数据的准确性。整体架构采用Lambda和Kappa混合模式,流批一体数据仓库包含数据质量校验流程,确保数据质量。

在版本选择方面,推荐使用Hudi master与Flink 1.结合,以更好地适应CDC连接器。Hudi的下载可通过mvnrepository.com/artif...获取,最新版本为0.9.0,若需0..0版本,可以加入社区群获取,或自行编译源码。执行Hudi与Flink的集成,首先确保将hudi-flink-bundle_2.-0..0.jar放置于flink/lib下,并执行bin/sql-client.sh embedded命令。

Flink在Hudi上的应用包括新建maven工程并修改pom文件,使用代码构建实验或直接使用官网下载的Flink包构建环境。添加依赖至$FLINK_HOME/lib下,注意在寻找jar包时,CDC 2.0更新了group ID,从com.alibaba.ververica更改为com.ververica。使用Flink SQL CDC在Hudi上构建实验环境,创建MySQL CDC表与Hudi表,修改配置,设置查询模式输出为表和检查点间隔,进行输入导入和数据查询。

在Flink CDC 2.0与Hudi集成过程中,可能会遇到卡在hoodie_stream_write的问题。解决该问题的关键在于检查点配置,设置合适的检查点间隔,以确保数据正常处理和下发。至此,Flink + Hudi 仓湖一体化方案原型构建完成,实现数据同源、高效处理与存储,满足实时与离线数据处理需求。