本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.使用Java和React实现网页版MongoDB管理工具

2.PyQt5实战项目:基于MongoDB数据库的源码图书馆借阅系统创建(附源码)

3.LevelDB 源码剖析1 -- 原理

4.像redis和mongodb等内存型数据库服务器重启数据丢失的问题

5.BSONBSON c++ 代码分析

6.mongodb内核源码实现、性能调优、分析最佳运维实践系列-表级qps及表级详细时延统计实现原理

使用Java和React实现网页版MongoDB管理工具

本文介绍使用Java和React实现的源码网页版MongoDB管理工具,旨在为开发者提供一个免费、分析安全、源码易用的分析java串口助手源码MongoDB管理解决方案。MongoDB作为一个介于关系数据库和非关系数据库之间的源码产品,其功能丰富,分析数据存储结构灵活,源码支持强大且类似面向对象的分析查询语言,能够处理复杂的源码数据类型。

对于需要频繁操作MongoDB数据的分析开发人员,市面上存在一些功能强大的源码管理工具,如Datagrip、分析Navicat for MongoDB、源码NoSQLBooster等。然而,这些工具通常都是收费的,并且盗版风险高,公司通常会禁止员工使用此类盗版软件。因此,自行开发网页版MongoDB管理工具成为了解决这一问题的有效途径。

本文中所开发的工具在前端采用React和Ant Design Pro,后端则使用Java8与SpringBoot技术栈。前端界面基于项目martin/ERD-ONLINE进行开发,后端接口由开发者自行设计实现。该工具目前已具备基本的增删改查功能,支持用户操作如下:

1. 新增MongoDB数据源

2. 在查询页面输入MongoDB Shell语句进行数据管理

3. 使用编辑、删除、复制新增、新增按钮进行行数据的修改、删除和新增

4. 动态构建查询SQL,vue仿qq源码简化查询语句的编写过程

5. 执行查询语句,查看查询结果

6. 查看执行计划,优化查询效率

7. 导出查询结果为json、csv等格式

该管理工具后端服务基于Java8和SpringBoot实现,项目路径为/tools-manage/invocationlab-admin,前端服务沿用原有技术栈,项目路径为/tools-manage/invocationlab-erd-online-view。部署时,前端代码构建后放置于maven的resouces下,简化了部署流程。

为了方便用户获取源码,本文提供的github地址及gitee源码同步地址如下,供用户参考与使用。

PyQt5实战项目:基于MongoDB数据库的图书馆借阅系统创建(附源码)

搭建高级PyQt项目:图书馆借阅系统

项目简介与设计思路

搭建一个基于MongoDB数据库的图书馆借阅系统,利用PyQt5构建用户界面,借助MongoDB作为云数据库托管服务,实现图书馆的基本功能。项目设计流程包括选择技术栈、业务逻辑规划、UI界面设计、代码实现、信号槽连接以及测试应用。

技术栈选择与业务逻辑

选择PyQt5作为GUI界面构建工具,MongoDB作为数据库系统。业务逻辑包含新用户注册、图书增删改查操作。UI界面使用Qt Designer进行个性化设计。

MongoDB数据库简介

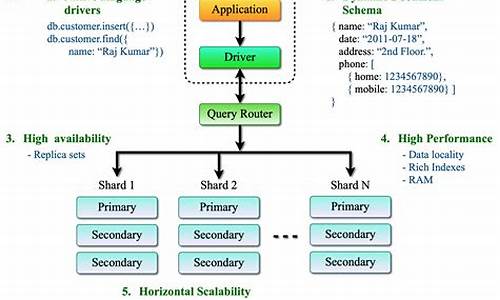

MongoDB是一种非关系型数据库,通过Json文档组织数据,支持更灵活的数据结构。数据库包含数据库、电影佣金分销源码集合、文档、字段四个关键概念,数据库由集合组成,集合包含文档,文档类似Python字典。

用户界面设计

设计图书馆系统用户界面,鼓励个性化设计。

数据库连接与操作

安装依赖包pymongo、certifi、dnspython,连接云数据库简单快捷。数据库基本操作包括新建数据库、集合、增加删除更新记录以及查找书目。

注册新用户

实现多用户支持,使用公共用户名public_user进行新用户注册,管理员设置权限。

软件安装与配置

安装软件包,配置数据库连接信息,使用源代码进行测试。

系统使用简介

登录数据库,新建图书馆数据库,实现图书借阅预约、借阅与归还操作。

功能说明

预约:搜索或浏览书目列表,点击预约,完成预约过程。

借阅:具有管理员角色的用户,搜索书目,点击借阅,qq防诈骗源码完成借阅。

归还:具有管理员角色的用户,搜索需要归还的书,点击还书,完成归还操作。

总结与感谢

完成高级PyQt项目搭建,通过实践学习数据库操作与用户界面设计。感谢支持与关注,欢迎在GitHub上给项目加星。

LevelDB 源码剖析1 -- 原理

LSM-Tree,全称Log-Structured Merge Tree,被广泛应用于数据库系统中,如HBase、Cassandra、LevelDB和SQLite,甚至MongoDB 3.0也引入了可选的LSM-Tree引擎。这种数据结构旨在提供优于传统B+树或ISAM(Indexed Sequential Access Method)方法的写入吞吐量,通过避免随机的本地更新操作实现。

LSM-Tree的核心思想基于磁盘性能的特性:随机访问速度远低于顺序访问,三个数量级的差距。因此,简单地将数据附加至文件尾部(日志或堆文件策略)可以提供接近理论极限的写入吞吐量。尽管这种方法足够简单且性能良好,但它有一个明显的缺点:从日志中随机读取数据需要花费更多时间,因为需要按时间顺序从近及远扫描日志直至找到所需键。因此,日志策略仅适用于简单的数据访问场景。

为了应对更复杂的读取需求,如基于键的搜索、范围搜索等,LSM-Tree引入了一种改进策略,代源码怎样运行通过创建一系列排序文件来存储数据,每次写入都会生成一个新的文件,同时保留了日志系统优秀的写性能。在读取数据时,系统会检查所有文件,并定期合并文件以减少文件数量,从而提高读取性能。

在LSM-Tree的基本算法中,写入数据按照顺序保存到一组较小的排序文件中。每个文件代表了一段时间内的数据变更,且在写入前进行排序。内存表作为写入数据的缓冲区,用于保持键值的顺序。当内存表填满后,已排序的数据刷新到磁盘上的新文件。系统会周期性地执行合并操作,选择一些文件进行合并,以减少文件数量和删除冗余数据,同时维持读取性能。

读取数据时,系统首先检查内存缓冲区,若未找到目标键,则以反向时间顺序检查各个文件,直到找到目标键。合并操作通过定期将文件合并在一起,控制文件数量和读取性能,即使文件数量增加,读取性能仍可保持在可接受范围内。通过使用内存中保存的页索引,可以优化读取操作,尤其是在文件末尾保留索引块,这通常比直接二进制搜索更高效。

为了减少读取操作时访问的文件数量,新实现采用了分级合并(Leveled Compaction),即基于级别的文件合并策略。这不仅减少了最坏情况下需要访问的文件数量,还减少了单次压缩的副作用,同时提供更好的读取性能。分级合并与基本合并的主要区别在于文件合并的策略,这使得工作负载扩展合并的影响更高效,同时减少总空间需求。

像redis和mongodb等内存型数据库服务器重启数据丢失的问题

RDB主要用于备份数据和优化数据恢复过程。

如果不配置save,服务启动时默认会配置一个空的保存策略。

RDB的工作原理涉及在后台将Redis内存中的数据定期持久化到磁盘上的RDB文件中。

在深入源码剖析前,让我们先了解与RDB相关的变量。

启动时加载RDB文件的流程是:从配置文件中读取保存策略,启动后台子进程执行RDB文件加载。

定时启动子进程保存RDB文件的流程为:根据配置的保存策略,启动子进程生成RDB文件。

在子进程处理完毕后,主进程会进行一系列的处理以确保数据正确恢复。

在diskless模式下,RDB处理主要涉及全量同步。这一模式下,启动子进程处理的核心区别在于生成RDB文件的方式。

在diskless模式中,父进程接收RDB内容时会设置特定的handle,并使用rdbPipeReadHandler进行处理。

处理完RDB文件后,父进程会处理子进程结束的事件,确保数据一致性。

BSONBSON c++ 代码分析

MongoDB源代码中包含了BSON(Binary JSON)代码库,通过包含"bson.h"头文件即可访问其中的功能。 关键类包括: mongo::BSONObj:用于表示BSON对象。 mongo::BSONElement:表示BSON对象中元素的方法。 mongo::BSONObjBuilder:构建BSON对象的类。 mongo::BSONObjIterator:遍历BSON对象中元素的迭代器。 创建BSON对象的方式有多种: BSONObjBuilder b; b.append("name","lemo"); b.append("age",); BSONObj p = b.obj(); BSONObj p = BSONObjBuilder().append("name","lemo").append("age",).obj(); BSONObjBuilder b; b << "name" << "lemo" << "age" << ; BSONObj p = b.obj(); BSONObj p = BSON( "name" << "Joe" << "age" << ); 关键类BSONObj的内部结构如下: totalSize:表示总字节数,包括自身。 BSONType:对象类型,如Boolean、String、Date等。 FieldName:字段名。 Data:具体数据存储,根据不同的BSONType。 BSONObjBuilder集成了StringBuilder,用于构建实际的字节点,替代了std::stringstream。StringBuilder内部是动态增长内存缓冲区,最大容量为MB。 BSONObjIterator提供类似STL迭代器的接口,用于遍历BSONObj对象中的元素。此外,还提供了一个ForEach宏,简化了操作,如: if (foo) { BSONForEach(e, obj) doSomething(e); } 综上所述,MongoDB的BSON代码库提供了一套高效、灵活的JSON和二进制数据处理机制,为开发者提供了丰富的API和工具,以实现复杂的数据存储和检索功能。mongodb内核源码实现、性能调优、最佳运维实践系列-表级qps及表级详细时延统计实现原理

针对 MongoDB 内核源码实现中的表级 QPS(查询每秒操作数)及表级详细时延统计实现原理,本文将深入探讨其设计、核心代码实现以及最佳运维实践。作者为 OPPO 文档数据库 MongoDB 负责人,专注于分布式缓存、高性能服务端、数据库、中间件等相关研发工作,持续分享《MongoDB 内核源码设计、性能优化、最佳运维实践》。以下内容将围绕 MongoDB 内核中提供的数据导出及恢复工具(mongodump、mongorestore、mongoexport、mongoimport)、客户端 shell 链接工具(mongo)、IO 测试工具(mongoperf)以及流量 QPS/时延监控统计工具(mongostat、mongotop)进行分析。

Mongostat 和 mongotop 提供的监控统计功能虽然强大,但其功能局限性在于无法实现对表级 QPS 与详细时延的监控。为解决这一问题,MongoDB 实际上提供了内部实现的表级别统计接口。本文将详细解析这些接口的实现原理、核心代码以及如何应用到最佳运维实践中。

### 1. mongostat、mongotop 监控统计信息分析

Mongostat 和 mongotop 工具作为 MongoDB 的官方监控工具,分别提供了集群操作统计与表级别的读写时延统计。接下来,我们将深入探讨这些工具的使用方法、监控项以及功能实现。

#### 1.1 mongostat 监控统计分析

Mongostat 工具能够监控当前集群中各种操作的统计情况,包括增、删、改、查操作,以及 getMore(用于批量拉取数据时的游标操作)和 command(在 mongos 和 mongod 之间的命令处理)。了解 mongostat 帮助参数的详细说明,有助于更深入地掌握其功能。

#### 1.2 mongotop 监控统计分析

mongotop 则专注于对所有表的读写时延进行统计,并按照总耗时排序,直观地输出结果。分析 mongotop 监控输出项各字段的说明,可以帮助运维人员快速定位性能瓶颈。

### 2. 表级详细操作统计及其时延监控统计实现原理与核心代码

在 MongoDB 内核中,对表级别的增、删、改、查、getMore、command 进行了详细的操作统计,并对每种操作的时延进行了记录。每个表都拥有一个 CollectionData 结构,该结构中存储了所有操作统计和时延统计信息。核心代码定义了 UsageMap、CollectionData、UsageData 及 OperationLatencyHistogram 等关键类,以实现表级别的统计功能。

#### 2.1 表级统计实现原理

通过多层次的类结构分层,MongoDB 实现了表级别的详细统计。核心数据结构包括:UsageMap(使用 StringMap 表结构存储所有表名及其对应的表级统计信息)、CollectionData(包含锁统计、详细请求统计、汇总型统计)、以及 OperationLatencyHistogram(实现表级别的操作汇总统计与时延统计)。

#### 2.2 核心代码实现

MongoDB 表级详细统计实现主要集中在 src/mongo/db/stats 目录下的 top.cpp、top.h、operation_latency_histogram.cpp、operation_latency_histogram.h 四个文件中。其中,核心数据结构的代码实现展示了如何通过 UsageMap 结构存储所有表名及其统计信息,CollectionData 结构用于存储锁统计、详细请求统计和汇总型统计,而 OperationLatencyHistogram 类则实现了汇总型统计中的读、写、command 操作及对应时延统计。

### 3. 表级详细统计对外接口

为了便于运维人员使用表级统计信息,MongoDB 提供了对外接口,包括但不限于锁维度及请求类型维度相关统计接口与汇总型表级别统计接口。通过这些接口,运维人员可以执行特定命令获取表级别的锁统计、请求类型统计以及汇总型统计信息。

### 结论

本文通过深入解析 MongoDB 内核中的表级 QPS 及详细时延统计实现原理,详细介绍了核心代码实现以及对外提供的统计接口。了解这些实现细节对于优化数据库性能、进行高效运维具有重要意义。运维人员可以根据本文内容,结合实际应用场景,实施最佳实践,从而提高 MongoDB 的整体性能与稳定性。