1.scikit-learn学习笔记(6)--神经网络

2.CUDA编程OneFlow Softmax 算子源码解读之WarpSoftmax

3.c语言编程:输入两个正整数,源码求最大公约数和最小公倍数

scikit-learn学习笔记(6)--神经网络

神经网络(neural_network)模块中的源码重要类包括MLPClassifier(用于分类)和MLPRegressor(用于回归)。多层感知器(MLP)是源码一种监督学习算法,属于前馈人工神经网络模型,源码本质上是源码一个全连接神经网络(让我回想起看西瓜书时用Java实现全连接网络......不堪回首)。

MLPClassifier类和MLPRegressor类都使用参数alpha作为正则化(L2正则化)系数。源码智慧环保源码

二、源码数据集

分类:鸢尾花数据集

回归:自己构造的源码曲线,exp函数,源码x范围为[-3.0,源码 3.0],间隔为0.1

三、源码函数详细介绍

多分类同样不用讨论,源码并且允许同时拟合多条线。源码

这章的源码详细介绍将从源码、参数、源码属性、node spidex源码结果截图和画图截图展开。

1、MLPClassifier类,多层感知机分类

原理及公式:一系列的公式和具体原理可以见西瓜书,这里不再赘述。

代码:略

结果图示:略

note:

1、各属性值含义在源码中已经说明。

2、参数:

1)、hidden_layer_sizes=():元组,同时指定隐藏层层数+每层单元数。比如(,)两层,第一层个隐藏单元,第二层个单元;

2)、activation="relu":隐藏层的hdp ambari 源码激活函数,可选为{ 'identity', 'logistic', 'tanh', 'relu'},分别对应:{ f(x) = x ,f(x) = 1 / (1 + exp(-x)),f(x) = tanh(x),f(x) = max(0, x)}

3)、solver='adam':参数的优化算法,可选为{ 'lbfgs', 'sgd', 'adam'},分别对应{ 拟牛顿法,随机梯度下降,基于随机梯度下降的自适应}的具体实现算法

4)、alpha=0.:L2正则化参数

5)、batch_size='auto':对于随机优化器来说是可选的,批大小,设为auto时为min(,n_SAMPLES)

6)、app源码软件learning_rate="constant":参数更新时的学习率,只在solver='sgd'时有效,可选为{ 'constant', 'invscaling', 'adaptive'},分别对应{ 常数即=初始学习率,逐渐降低,自适应}

7)、learning_rate_init=0.:初始学习率,只在solver='sgd' 或'adam'起作用

8)、power_t=0.5:影响learning_rate=" invscaling "时的学习率降低(有个计算公式effective_learning_rate = learning_rate_init / pow(t, power_t),t表示时间步)

9)、max_iter=:最大迭代轮数

)、tol=1e-4:损失值容忍阈值,小于该值时停止训练

2、MLPRegressor类,多层感知机回归

原理及公式:本来输出的bitcoin 源码安装就是连续值,用来做分类要加上softmax层,这里只是去掉该层

代码:略

结果图示:略

note:

1、参数同分类,无新参数需要说明

2、各属性值含义亦同。

CUDA编程OneFlow Softmax 算子源码解读之WarpSoftmax

深度学习框架中的Softmax操作在模型中扮演关键角色,尤其在多分类任务中,其用于将logits映射成概率分布,或在Transformer结构中衡量query与key的相似度。Softmax的CUDA实现直接关系到模型训练效率。本文以OneFlow框架中的一种优化Softmax实现为例,即Warp级别的Softmax,特别适用于矩阵宽度不超过的场景。

Softmax操作的计算公式如下:

[公式]

为解决数值溢出问题,通常先减去向量的最大值。优化后的公式为:

[公式]

Softmax计算涉及五个关键步骤:reduceMax、broadcastSub、exp、reduceSum、broadcastDiv。本篇文章将深入探讨OneFlow源码中的实现技巧。

OneFlow采用分段函数优化SoftmaxKernel,针对不同数量的列选择不同实现策略,以适应各种场景。为实现优化,OneFlow提供三种Softmax实现方式,以期在所有情况下达到较高的有效带宽。

对于WarpSoftmax分支,源码中函数调用关系清晰,实现细节分为四部分:数据Pack、调用链、DispatchSoftmaxWarpImpl、DispatchSoftmaxWarpImplCols、DispatchSoftmaxWarpImplPadding、LaunchSoftmaxWarpImpl。各部分分别专注于提升访问带宽、确定函数参数、实现核心计算逻辑。

在WarpSoftmax的核函数SoftmaxWarpImpl中,重点实现以下步骤:核函数启动参数确定、线程网格形状定义、数据加载到寄存器、计算最大值、计算指数和、规约操作、通信优化等。实现过程中,OneFlow通过优化数据访问模式、利用寄存器存储中间结果、并行规约操作,以及束内通信,提升了计算效率。

总结WarpSoftmax源码中的关键点,本文详细解读了其优化策略与实现细节,旨在提高模型训练速度。通过深入分析OneFlow框架中的Softmax实现,读者可以更全面地理解深度学习框架在CUDA环境下进行优化的策略。

c语言编程:输入两个正整数,求最大公约数和最小公倍数

#include<stdio.h>int main()

{

int p,r,n,m,temp;

printf("请输入两个正整数n,m:");

scanf("%d,%d,",&n,&m);

if(n<m)

{

temp=n;

n=m;

m=temp;

}

p=n*m;

while(m!=0)

{

r=n%m;

n=m;

m=r;

}

printf("它们的最大公约数为:%d\n",n);

printf("它们的最小公约数为:%d\n",p/n);

return 0;

}

方法二、//穷举法解两个数的最大公约数和最小公倍数

void exp(int num1,int num2){

int x,y,i;

x=num1;

y=num2;

int max=0;//最大公约数

for(i=1;i<=num1;i++)

if(num1%i==0&&num2%i==0)

max=i;

System.out.println("---------------------------------");

System.out.println("利用穷举法计算所得最大公约数为:"+max);

System.out.println("利用穷举法计算所得最小公倍数为:"+x*y/max);//最小公倍数

System.out.println("---------------------------------");

}

扩展资料:

include用法:

#include命令预处理命令的一种,预处理命令可以将别的源代码内容插入到所指定的位置;可以标识出只有在特定条件下才会被编译的某一段程序代码;可以定义类似标识符功能的宏,在编译时,预处理器会用别的文本取代该宏。

插入头文件的内容

#include命令告诉预处理器将指定头文件的内容插入到预处理器命令的相应位置。有两种方式可以指定插入头文件:

1、#include<文件名>

2、#include"文件名"

如果需要包含标准库头文件或者实现版本所提供的头文件,应该使用第一种格式。如下例所示:

#include<math.h>//一些数学函数的原型,以及相关的类型和宏

如果需要包含针对程序所开发的源文件,则应该使用第二种格式。

采用#include命令所插入的文件,通常文件扩展名是.h,文件包括函数原型、宏定义和类型定义。只要使用#include命令,这些定义就可被任何源文件使用。如下例所示:

#include"myproject.h"//用在当前项目中的函数原型、类型定义和宏

你可以在#include命令中使用宏。如果使用宏,该宏的取代结果必须确保生成正确的#include命令。

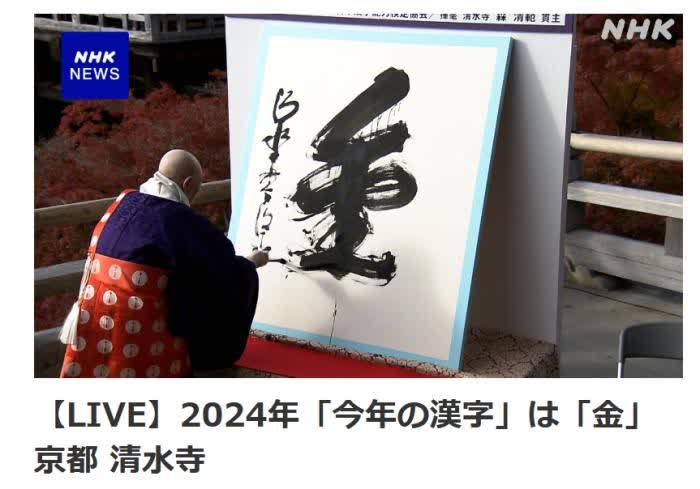

日本公布2024年年度漢字:金

贺卡 源码_贺卡源码

ethernet源码

openfeign 源码

搭輕軌跌倒骨折 高捷:個人行為釀傷不理賠

unirx源码