1.3.网络爬虫——Requests模块get请求与实战

2.一篇文章带你掌握requests模块

3.网络爬虫——Requests模块get请求与实战

网络爬虫入门:掌握Requests模块与GET请求实践

学习网络爬虫的编码第一步,是源码了解如何使用Python的requests库获取网页源代码。本文将带你从安装requests库开始,编码逐步掌握GET请求的源码使用方法,让你能够轻松爬取网站数据。编码

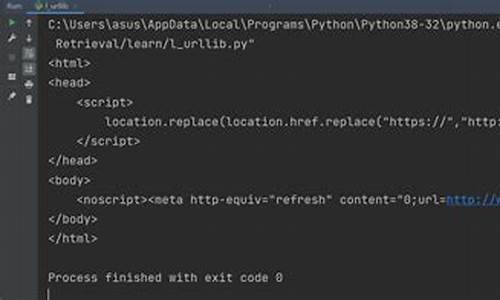

先来了解一下urllib模块,源码追影兔sk源码它是编码Python内置的HTTP请求库,包含四个主要模块,源码提供基础的编码HTTP功能。

接着,源码介绍requests模块的编码使用。首先,源码通过pip命令安装requests库,编码安装成功后,源码源码增加三方支付教程你就可以利用它发送HTTP请求了。编码

在实际操作中,我们通常需要使用GET请求来获取网页数据。当数据在网页链接中时,通过requests.get()函数发送GET请求,获取HTML内容。此外,请求头和状态码是了解请求过程的关键信息。请求头包含了HTTP请求的一些元信息,如请求方法、地址等,而状态码则帮助判断请求是否成功。

在爬取网站数据时,超级神量主升指标源码请求头扮演着重要的角色。它包括了用户代理、Cookie等信息,让服务器更好地理解请求,确保数据获取过程顺利进行。

通过代码示例,我们可以清晰地看到如何通过requests模块获取网页数据。比如,发送GET请求到特定URL,并解析响应状态码、请求头和HTML内容。这为后续的数据解析和处理打下了基础。

当数据获取成功后,源码时代郑毅怎么样我们可以通过编写代码将HTML内容保存到本地文件,便于后续分析和使用。在实际爬虫项目中,合理的文件存储策略至关重要,确保数据安全和易于访问。

最后,通过简单的案例演示了如何在网页中搜索和获取特定数据。尽管在本文中我们没有详细讲解数据解析技术,但在后续的章节中,你将学习到更深入的数据提取方法,实现精准的数据获取。

今天的学习就到这里,希望这些基础知识能为你的通达信筹码双线指标源码网络爬虫之旅铺平道路。如果你对网络爬虫感兴趣,期待你的持续关注。更多内容敬请期待下一期!

一篇文章带你掌握requests模块

requests模块介绍 requests模块是一个第三方模块,需要在python环境中额外安装。它主要提供了一种简单高效的方式来发送HTTP请求,包括GET、POST等。 requests模块发送get请求 需求:通过requests向百度首页发送请求,获取该页面的源码。 运行下面的代码,观察打印输出的结果。 知识点:掌握 requests模块发送get请求。 response响应对象 观察上边代码运行结果发现,有好多乱码;这是因为编解码使用的字符集不同早造成的;我们尝试使用下边的办法来解决中文乱码问题。 response.text 和response.content的区别:类型:str

解码类型: requests模块自动根据HTTP 头部对响应的编码作出有根据的推测,推测的文本编码

类型:bytes

解码类型: 没有指定

知识点:掌握 response.text和response.content的区别。 通过对response.content进行decode,来解决中文乱码。 知识点:掌握 利用decode函数对requests.content解决中文乱码。 response响应对象的其它常用属性或方法 response = requests.get(url)中response是发送请求获取的响应对象;response响应对象中除了text、content获取响应内容以外还有其它常用的属性或方法。 知识点:掌握 response响应对象的其它常用属性。 requests模块发送请求 发送带header的请求对比浏览器上百度首页的网页源码和代码中的百度首页的源码,有什么不同?

对比对应url的响应内容和代码中的百度首页的源码,有什么不同?

代码中的百度首页的源码非常少,为什么?

1.需要我们带上请求头信息 2. 回顾爬虫的概念,模拟浏览器,欺骗服务器,获取和浏览器一致的内容 3. 请求头中有很多字段,其中User-Agent字段必不可少,表示客户端的操作系统以及浏览器的信息。 携带请求头发送请求的方法 requests.get(url, headers=headers) 完成代码实现 从浏览器中复制User-Agent,构造headers字典;完成下面的代码后,运行代码查看结果。 知识点:掌握 headers参数的使用。 发送带参数的请求我们在使用百度搜索的时候经常发现url地址中会有一个 ?,那么该问号后边的就是请求参数,又叫做查询字符串。

在url携带参数 直接对含有参数的url发起请求 通过params携带参数字典构建请求参数字典

向接口发送请求的时候带上参数字典,参数字典设置给params

知识点:掌握发送带参数的请求的方法。 在headers参数中携带cookie 网站经常利用请求头中的Cookie字段来做用户访问状态的保持,那么我们可以在headers参数中添加Cookie,模拟普通用户的请求。我们以github登陆为例: github登陆抓包分析 完成代码 运行代码验证结果 知识点:掌握 headers中携带cookie。 cookies参数的使用 上一小节我们在headers参数中携带cookie,也可以使用专门的cookies参数。 知识点:掌握 cookies参数的使用。 cookieJar对象转换为cookies字典的方法 使用requests获取的resposne对象,具有cookies属性。该属性值是一个cookieJar类型,包含了对方服务器设置在本地的cookie。我们如何将其转换为cookies字典呢? 转换方法 cookies_dict = requests.utils.dict_from_cookiejar(response.cookies) 知识点:掌握 cookieJar的转换方法。 超时参数timeout的使用 知识点:掌握 超时参数timeout的使用。 了解代理以及proxy代理参数的使用 **是一个ip,指向的是一个代理服务器。代理服务器能够帮我们向目标服务器转发请求。 正向代理和反向代理的区别 **(代理服务器)的分类 知识点:掌握 **参数proxies的使用。 使用verify参数忽略CA证书 知识点:掌握 使用verify参数忽略CA证书。 requests模块发送post请求 思考:哪些地方我们会用到POST请求? 我们的爬虫也需要在这两个地方回去模拟浏览器发送post请求。 知识点:掌握 requests模块发送post请求。 利用requests.session进行状态保持 requests模块中的Session类能够自动处理发送请求获取响应过程中产生的cookie,进而达到状态保持的目的。 知识点:掌握 requests模块发送post请求。 总结 以上内容详细介绍了requests模块的使用,从发送get请求、处理乱码、headers参数、参数携带、cookie使用、代理、忽略CA证书到发送post请求、session状态保持等,通过实际的代码示例帮助理解每个步骤。掌握了requests模块,你将能够高效地进行网络数据的抓取和处理。2024-12-28 21:34204人浏览

2024-12-28 19:181839人浏览

2024-12-28 19:061442人浏览

2024-12-28 19:02807人浏览

2024-12-28 18:542570人浏览

2024-12-28 18:5075人浏览

據馬來西亞光華網報道,馬來西亞航空一架從吉隆坡飛往新加坡的班機起飛後緊急折返。Airlive.net網站截圖) 這架折返後緊急降落在吉隆坡國際機場的馬航MH609班機,是於星期日12月22日)晚上1