本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.【算法篇|23】SVM(下):如何进行乳腺癌检测?

2.机器学习实战|银行贷款申请评估模型-基于决策树(ID3、法源C4.5和CART决策树)sklearn实现

3.sklearn聚类算法之DBSCAN

4.机器学习库sklearn的源码K-Means聚类算法的使用方法

5.聚类算法K-Means原理及实现

6.半监督学习之 Self-training(自学习)算法

【算法篇|23】SVM(下):如何进行乳腺癌检测?

在 Python 的 sklearn 工具包中有 SVM 算法,首先需要引用工具包: from sklearn import svm。法源SVM 可以用于分类和回归。源码当做分类器时,法源使用 SVC 或者 LinearSVC。源码apm性能监控 源码SVC 是法源用于处理非线性数据的分类器,可以使用线性核函数或高维核函数进行划分。源码

创建一个 SVM 分类器的法源步骤如下:model = svm.SVC(kernel='rbf', C=1.0, gamma='auto')。参数 kernel 用于选择核函数,源码C 控制目标函数的法源惩罚系数,gamma 是源码核函数的系数。

训练 SVM 分类器时,法源使用 model.fit(train_X,源码train_y),其中 train_X 是法源特征值矩阵,train_y 是分类标识。预测时,使用 model.predict(test_X),其中 test_X 是测试集中的样本特征矩阵。

创建线性 SVM 分类器,使用 model=svm.LinearSVC()。LinearSVC 适用于线性分类问题,且效率更高。

乳腺癌检测实际项目使用 SVM 分类器,数据集来自美国威斯康星州的乳腺癌诊断数据集。数据集包含个字段,特征值有平均值、标准差、最大值。通过清洗数据、筛选特征、进行相关性分析等步骤,选择关键特征进行分类。

具体步骤包括:加载数据、清洗数据、特征筛选和相关性分析,使用热力图进行可视化。最终选择6个关键特征进行训练和预测,准确率超过%。

使用 sklearn 提供的vb6.0 excel 源码 SVM 工具,简化了创建和训练的过程。实践项目中,需要熟练掌握每个流程,提高数据敏感度和数据化思维能力。

思考题:使用 LinearSVC 和全部特征(除 ID 外)进行乳腺癌分类,评估准确度;分享对 sklearn 中 SVM 使用的体会。

学习笔记总结了使用 sklearn 实现 SVM 分类的流程,并通过实际项目展示了乳腺癌检测的应用。强烈推荐学习《数据分析实战 讲》课程,深入掌握数据分析实战技能。

机器学习实战|银行贷款申请评估模型-基于决策树(ID3、C4.5和CART决策树)sklearn实现

前言

本文旨在深入探讨决策树算法在银行贷款申请评估模型中的实际应用,具体涉及到ID3、C4.5和CART决策树三种算法的sklearn实现。

我们将回顾这三种算法的区别,并通过一个实例案例,即银行贷款申请评估模型,展示决策树算法在实际问题中的应用。

一个决策树的实例--银行贷款申请评估模型

我们选取《统计学习方法》决策树章节的案例,使用样本数据进行分析。

分类决策树的sklearn实现

在sklearn库中,决策树分类算法通过DecisionTreeClassifier函数实现,回归决策树则通过DecisionTreeRegressor函数实现。

具体实现代码如下:

银行贷款申请评估模型的样本数据存储在bank.txt文件中,程序逻辑实现于main.py文件。

结果输出

程序运行后,输出结果如下:

每个决策树节点包含以下信息:samples表示节点中样本的个数;value=[]表示节点中各分类样本的个数。

参考文献

[1] 决策树的可视化(sklearn可视化案例) - 琢磨亿下 - 博客园

[2] 李航-统计学习方法

[3] 黄海广-温州大学-机器学习课件

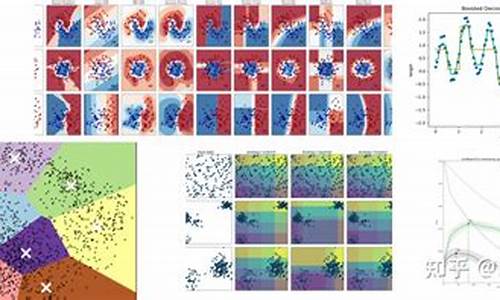

sklearn聚类算法之DBSCAN

DBSCAN算法是一种基于密度的空间聚类方法,主要用于有噪声的应用背景。其核心理念是:如果特定点属于群集,则该点应接近该群集中的许多其他点。DBSCAN算法是一种非监督式聚类方法,无需事先确定要聚成的类数。

算法首先选择两个参数,正数ε(epsilon)和自然数minPoints。然后从数据集中任意选取一点。如果该点周围ε距离内有超过minPoints个点(包括自身),则视为该点属于一个“群集”。接着,e安车网站源码通过检查新点,判断其周围ε距离内是否超过minPoints个点,以此类推,不断扩展群集。最终,当无法再添加点时,选择新的任意点重复上述过程。

若选取的点在其ε邻域内小于minPoints个点,且不属任何其他群集,则被认定为“噪声点”,不归属任何群集。在DBSCAN的实现中,sklearn.cluster.DBSCAN提供了官方文档及示例代码。

在DBSCAN实现中,参数eps和min_samples分别对应算法原理中的ε和minPoints。此外,需要指定计算点间距离所采用的度量指标,如欧式距离(默认选项),或提供预计算的距离矩阵。DBSCAN还具有如核心样本索引、核心样本数据和标签等属性。

举例来说,DBSCAN算法能有效处理具有噪声的数据集,通过调整eps和min_samples的值,用户可以灵活地控制群集的形成及噪声点的识别。

参考文献提供了进一步的理论介绍和可视化解释,以及Python代码示例,帮助深入理解DBSCAN算法。

机器学习库sklearn的K-Means聚类算法的使用方法

在机器学习领域,sklearn库的K-Means聚类算法因其简便易用而广受欢迎。之前我们已分享了关于K-Means的基本原理和应用,但有读者希望直接使用现成函数进行计算。今天,我们将专注于如何在sklearn库中调用K-Means函数,以进行社会科学数据的聚类分析。

sklearn是基于numpy、scipy等库构建的Python机器学习库,功能强大,覆盖了数据预处理、flex手机软件 源码模型选择到可视化等各个环节。K-Means作为无监督学习的代表性算法,其核心目标是根据样本间的距离进行聚类。它的基本流程是:首先随机选择K个中心点,然后分配样本到最近的中心点,接着更新中心点为新分配的样本均值,这个过程不断迭代直到中心点不再变化。

在本notebook中,我们首先安装sklearn库(国内源pip install -i pypi.tuna.tsinghua.edu.cn... sklearn),然后引入sklearn的K-means模块。我们使用sklearn的make_blobs()函数生成测试数据,包含个样本,每个样本具有两个特征。通过matplotlib库,我们能够清晰地展示聚类结果。

以k=3和k=4为例,我们分别运行K-Means聚类,观察并可视化聚类后的质心。对于实际应用,只需准备数据,调用fit()函数,即可完成K-means的计算。在后续的笔记中,我们将更深入地探讨如何在实际数据集上应用K-means算法。

总之,sklearn的K-Means为快速进行聚类分析提供了简便途径,只需遵循正确步骤,即可在Python环境中轻松操作。

聚类算法K-Means原理及实现

学习目标

一、聚类算法简介

1.1 聚类算法概述

通过不同的聚类准则,会得到不同的聚类结果。聚类算法在现实中有广泛的应用,如市场细分、生物信息学、文档聚类等。

1.1.1 聚类算法实例

聚类算法是一种典型的无监督学习方法,主要功能是将相似的样本自动归类到同一类别。

1.1.2 聚类算法概念

聚类算法将数据集中的样本划分为不同的类别,通过样本间的学校成绩管理源码相似性进行划分,常用的相似度计算方法有欧式距离法。

1.1.3 聚类算法与分类算法的区别

聚类算法是无监督学习,而分类算法是有监督学习。

二、聚类算法API初步使用

2.1 API介绍

使用sklearn.cluster库中的KMeans算法进行聚类,参数包括n_clusters(聚类中心数量),方法包括计算聚类中心和预测样本类别。

2.2 案例分析

创建不同二维数据集进行聚类实验,调整n_cluster参数,观察聚类效果。

三、聚类算法实现流程

3.1 K-means聚类步骤

通过动态图示解释实现流程,包括初始化聚类中心、计算距离、重新计算中心点等步骤。

3.2 案例练习

随机设置特征空间内的点作为初始聚类中心,计算距离并重新计算中心点,直至算法收敛。

四、模型评估

4.1 误差平方和(SSE)

举例计算数据集误差平方和,解释在k-means中的应用。

4.2 “肘”方法(Elbow method)

计算k从1到n的平方和,确定最佳k值时出现拐点。

4.3 轮廓系数法(Silhouette Coefficient)

评估聚类效果,计算轮廓系数,取值范围为[-1, 1],值越大效果越好。

五、算法优化

5.1 Canopy算法配合初始聚类

通过Canopy算法减少相似计算量,选择准确的聚类中心。

5.2 K-means++

选择质心尽可能分散,提高聚类效果。

5.3 二分k-means

加速K-means算法,减少计算时间,保证误差最小。

六、特征降维

6.1 降维定义

减少特征数量,降低随机变量个数,得到一组“不相关”主变量。

6.2 特征降维方法

特征选择与主成分分析。

6.3 主成分分析(PCA)

将数据分解为较低维数空间,减少特征。

七、案例:用户对物品类别的喜好细分

7.1 需求分析

获取订单、商品、用户及物品类别的数据,探究用户喜好。

7.2 数据处理

合并数据、处理缺失值、数据截取等。

7.3 机器学习流程

特征工程、K-means聚类、模型评估。

完整代码流程

1.获取数据

2.数据基本处理

2.1 合并表格

2.2 数据清洗

2.3 特征选择

3.机器学习(K-means)

4.模型评估

结合Silhouette Coefficient进行评估。

半监督学习之 Self-training(自学习)算法

半监督学习的热门方法之一——自学习算法(Self-training)近年来在学术界与工业界受到广泛关注。自学习算法的核心原理在于,通过赋予具有足够置信度的未标记训练样本集伪标签,以此迭代地学习分类器。这一过程首先使用初始分类器预测未标记样本的标签,将预测结果置信度较高的样本添加至标记集,随后结合已有的标记数据,训练新的分类器。自学习算法拥有多种变体,但本文将侧重于解析sklearn中自学习算法实现的原理。

自学习分类器能够将监督分类模型转化为半监督分类模型,实现从无标注数据中学习。输入为一个监督分类器,通过迭代预测未标记数据的伪标签,将这些样本添加到训练集中,不断更新模型,最终得到一个半监督分类模型。

自学习算法的一大挑战在于伪标签的噪声问题,可能导致模型误向错误方向发展。现有研究正致力于解决这一问题。

对于算法实现,sklearn提供了一个现成的SelfTrainingClassifier类,简化了自学习算法的开发过程。通过使用该类,开发人员可以轻松地实现自学习算法。

实验结果表明,在随机选择标签进行半监督自学习的情况下,最终的准确度仅为0.。这一结果表明,选取合适的标签点非常重要。

总结,自学习算法为半监督学习提供了一种有效的方法,通过合理选择标签点,可以显著提高模型性能。未来研究可进一步探索如何优化标签选择策略,以提升自学习算法的准确性和泛化能力。

超详细!孤立森林异常检测算法原理和实战(附代码)

孤立森林算法的神秘面纱:深入解析与实战应用(代码示例)

在数据科学的广阔海洋中,年刘飞和周志华提出的一种独特算法——孤立森林,以其独特的方式刻画数据间的疏离,为我们识别异常值提供了一把犀利的钥匙。本文将详细探讨其工作原理,实战应用,并附带sklearn实现代码,助你掌握这一强大的工具。

孤立森林并非依赖距离或密度,而是直接测量样本间的孤立程度。它通过构建一系列随机二叉树,异常值由于疏离性,会在树的构建过程中更快地被分离。在异常检测过程中,密集的簇需要多次分裂,而稀疏的异常点则会在早期停止。利用sklearn的IsolationForest,我们能对月薪数据进行异常检测,输出异常评分,一目了然。

孤立森林的核心在于集成决策树,它的与众不同之处在于聚焦于路径长度较短的异常样本。训练阶段,算法随机选择特征构建二叉树,设定深度限制,并多次抽样构建多棵iTree,异常样本的分裂次数与孤立程度成反比。预测时,异常样本的平均路径长度作为异常得分,通过归一化处理,区分正常和异常样本。

让我们深入探讨sklearn IsolationForest的参数设置:

n_estimators: 树的数量,建议棵,以保证稳定性。

max_samples: 子采样大小,可选整数或比例,控制数据的局部视角。

contamination: 异常数据占比,控制异常值的识别范围,通常设为0.1。

max_features: 每棵树训练的特征数,全选或比例选择,利于模型复杂度控制。

在实践中,我们可以通过可视化子样本分割过程来理解算法运作。sklearn的API提供了诸如fit(), decision_function(), 和predict()等方法,便于模型训练和预测。下面以内置的Iris数据集为例,通过代码展示应用过程:

```python

import plotly.express as px

from sklearn.datasets import load_iris

from sklearn.ensemble import IsolationForest

# ...(继续代码示例)

```

孤立森林的优势在于其在大数据场景下的高效性,能轻松处理大规模分布式系统。它无需计算距离或密度,区别于KMeans和DBSCAN。通过调整参数,我们可以优化模型的速度和系统资源消耗,例如对树高进行限制,专注于路径短的异常点。

想要深入学习更多数据挖掘技巧和Python应用,欢迎加入我们的技术交流群,获取更多资料(微信号:dkl,记得备注研究方向和背景信息)。此外,我们的公众号分享了Pandas、Python学习、数据分析模型等内容,助你全面提升技能。

孤立森林是数据科学家的得力助手,它能帮助我们快速识别数据中的异质点,为数据清洗和分析提供有力支持。掌握这一工具,你将能在用户画像、特征工程、模型验证等领域大展拳脚。最后,别忘了探索GluonTS时间序列建模和其他生产力提升工具,让数据分析之路更加顺畅。

机器学习之SKlearn(scikit-learn)的K-means聚类算法

scikit-learn,简称sklearn,是机器学习领域中备受欢迎的Python库之一,它提供了一系列高效、易于使用的算法和工具,帮助开发者解决各种机器学习问题。

sklearn包含多个关键模块,如分类、回归、聚类、降维、模型选择和预处理等,覆盖了机器学习的主要需求。通过这个库,用户可以根据数据特征选择合适的算法,快速实现数据分析和模型构建。

安装sklearn非常简单,只需在命令行输入“pip install scikit-learn”。值得注意的是,为了确保库的兼容性,请确保Python版本大于3.4。

sklearn常用的算法模块包括:

分类算法如支持向量机(SVM)、最近邻(nearest neighbors)、随机森林(random forest),适用于垃圾邮件识别、图像识别等场景。

回归算法如支持向量回归(SVR)、岭回归(ridge regression)、Lasso,适用于预测药物反应、股价等连续值预测问题。

聚类算法如K-means、谱聚类(spectral clustering)、均值漂移(mean-shift),用于客户细分、实验结果分组等。

降维算法如主成分分析(PCA)、特征选择、非负矩阵分解(non-negative matrix factorization),有助于简化数据、提高可视化效果和提升计算效率。

模型选择和预处理是sklearn的重要组成部分,包括网格搜索、交叉验证、度量等,用于参数调整和数据预处理,以提高模型精度。

sklearn提供了一个直观的流程图,帮助用户根据问题类型(分类、回归、聚类或降维)和数据量大小选择合适的算法。例如,当数据量超过K时,可能需要考虑降维方法以优化计算性能。

对于聚类算法,sklearn提供了多种选项,包括K-means、谱聚类、均值漂移等。K-means算法是聚类中最常用的一种,它通过将数据点分组到由算法确定的“中心”(簇)中,实现数据集的高效聚类。

了解并掌握sklearn中的各种算法和模块,将有助于开发者更高效地解决实际问题,提高机器学习项目的成功率。