1.成为一名k8s专家需要掌握哪些知识?当我读完k8s源码之后总结

2.k8sådockeråºå«

3.听GPT 讲K8s源代码--cmd(一)

4.深入理解k8s -- workqueue

5.k8s emptyDir 源码分析

6.Kubernetes —— Pod 自动水平伸缩源码剖析(上)

成为一名k8s专家需要掌握哪些知识?当我读完k8s源码之后总结

要成为一名Kubernetes(简称k8s)专家,源码有多需要系统性地掌握一系列关键知识与技能。源码有多首先,源码有多深入理解容器技术,源码有多包括容器的源码有多底层原理和实现机制,这是源码有多软件源码怎么运营Kubernetes能够高效管理资源的基础。接着,源码有多了解Kubernetes的源码有多计算模型,熟悉如何在集群中调度和管理容器。源码有多在存储方面,源码有多需要掌握如何在Kubernetes中配置和使用不同类型的源码有多存储卷,以支持各种工作负载的源码有多需求。

网络管理在Kubernetes中同样重要,源码有多包括掌握如何配置网络策略、源码有多服务发现和负载均衡,源码有多确保服务间的通信流畅。此外,了解Kubernetes的插件机制,即如何利用和扩展Kubernetes的生态系统,接入第三方服务和工具,是提升Kubernetes使用灵活性的关键。

深入研究Kubernetes的源码理解,不仅有助于开发者更精准地定位和解决问题,还能在定制和优化Kubernetes部署时发挥重要作用。学习Kubernetes的编排能力,包括配置Pod、Service、Deployment等核心资源,以及理解如何利用Kubernetes的自动化功能,如自动扩展、爱蜗影视源码滚动更新等。

在Kubernetes的自定义资源定义(CRD)开发方面,掌握如何定义和操作自定义的资源类型,以满足特定业务场景的需求,是提高Kubernetes应用复杂度和灵活性的重要技能。最后,对Prometheus等监控工具的全组件学习,能够帮助Kubernetes专家构建全面的监控和报警机制,确保集群的稳定运行。

通过上述知识体系的学习和实践,一名Kubernetes专家将能够熟练地规划、部署、管理和优化大规模的Kubernetes集群,应对各种复杂场景和挑战,成为企业级分布式系统运维和开发的高效工具。

k8sådockeråºå«

k8sådockeråºå«:1ãææ¯åçä¸å

Dockersæ¯å®¹å¨åææ¯ï¼K8Sæ¯ä¸å¥èªå¨åé¨ç½²å·¥å ·ï¼å¯å ¨çå½å¨æ管çDockers容å¨ãK8Sæ¯è°·æå¼åç容å¨é群管çç³»ç»ãå¨Dockersææ¯çåºç¡ä¸ï¼ä¸ºå®¹å¨åçåºç¨æä¾é¨ç½²è¿è¡ãèµæºè°åº¦ãæå¡åç°åå¨æ伸缩çä¸äºåå®æ´åè½ï¼æé«äºå¤§è§æ¨¡å®¹å¨é群管çç便æ·æ§ã

2ãå¹³å°ä¸å

K8Sæ¯ä¸ä¸ªå®å¤çåå¸å¼ç³»ç»æ¯æå¹³å°ï¼å ·å¤å®åçé群管çè½åï¼å¤æ©å¤å±æ¬¡çå®å ¨é²æ¤ååå ¥æºå¶ãå¤ç§æ·åºç¨æ¯æè½åãéæçæå¡æ³¨åååç°æºå¶ãå 建æºè½è´è½½åè¡¡å¨ã强大çæ éåç°åèªæä¿®å¤è½åãæå¡æ»å¨å级åå¨çº¿æ©å®¹è½åãå¯æ©å±çèµæºèªå¨è°åº¦æºå¶ä»¥åå¤ç²åº¦çèµæºé é¢ç®¡çè½åã

Dockeræ¯ä¸ä¸ªå¼æºçåºç¨å®¹å¨å¼æï¼è®©å¼åè å¯ä»¥æå å®ä»¬çåºç¨ä»¥åä¾èµå å°ä¸ä¸ªå¯ç§»æ¤çéåä¸ï¼ç¶ååå¸å°ä»»ä½æµè¡çLinuxæWindowsæºå¨ä¸ï¼ä¹å¯ä»¥å®ç°èæåã

3ãæ¶æ模å¼ä¸å

Docker使ç¨å®¢æ·ç«¯ââæå¡å¨æ¶æ模å¼ï¼ä½¿ç¨è¿ç¨APIæ¥ç®¡çåå建Docker容å¨ãDockeif容æç½éè¿Dockeréåæ¥å建ï¼å®¹å¨ä¸éåçå ³ç³»ç±»ä¼¼äºé¢å对象ç¼ç¨ä¸ç对象ä¸ç±»ã

k8sådockerç®ä»ï¼

k8sçå ¨ç§°kubernetesãå®æ¯ä¸ä¸ªå®æ´çåå¸å¼ç³»ç»æ¯æå¹³å°,é群管çåè½é½å ¨ãKubernetesåæ¶æä¾å®åç管çå·¥å ·ï¼æ¶µçäºå¼åãé¨ç½²ãæµè¯ãè¿è¡çæ§çå个ç¯èãk8sæ¯ä¸ç§å¼æ¾æºç ç容å¨é群管çç³»ç»ï¼è½å¤å®ç°èªå¨åé¨ç½²ãæ©å±å®¹å¨é群ãç»´æ¤çåè½ã

Dockeræ¯ä¸ç§å¼æ¾æºç çåºç¨å®¹å¨å¼æ,å 许å¼å人åå°å ¶åºç¨åä¾èµå æå æå¯ç§»æ¤çéå,ç¶ååå¸å°ä»»ä½æµè¡çLinuxæWindowsæºå¨ä¸,ä¹è½å®ç°èæåã该容å¨å®å ¨ä½¿ç¨æ²ç®±æºå¶,å½¼æ¤ä¹é´æ²¡æä»»ä½æ¥å£ãDockeræ¯ä¸ç§å¼æ¾æºç çåºç¨å®¹å¨å¼æ,å¼åè å¯ä»¥å°ä»ä»¬çåºç¨åä¾èµæå å¨ä¸ä¸ªå¯ç§»æ¤ç容å¨ä¸ ,åå¸å°æµè¡çLinuxæºå¨ä¸,ä¹å¯ä»¥å®ç°èæåã

听GPT 讲K8s源代码--cmd(一)

在 Kubernetes(K8s)的cmd目录中,包含了一系列命令行入口文件或二进制文件,它们主要负责启动、管理和操控Kubernetes相关组件或工具。这些文件各司其职,如:

1. **check_cli_conventions.go**: 该文件作用于检查CLI约定的规范性,确保命令行工具的一致性和易用性。它提供函数逐项验证命令行工具的帮助文本、标志名称、标志使用、输出格式等,输出检查结果并提供改进意见。

2. **cloud_controller_manager**: 这是启动Cloud Controller Manager的入口文件。Cloud Controller Manager是超排系统源码Kubernetes控制器之一,负责管理和调度与云平台相关的资源,包括负载均衡、存储卷和云硬盘等。

3. **kube_controller_manager**: 定义了NodeIPAMControllerOptions结构体,用于配置和管理Kubernetes集群中的Node IPAM(IP地址管理)控制器。此文件包含配置选项、添加选项的函数、应用配置的函数以及验证配置合法性的函数。

4. **providers.go**: 用于定义和管理云提供商的资源。与底层云提供商进行交互,转换资源对象并执行操作,确保Kubernetes集群与云提供商之间的一致性和集成。

5. **dependencycheck**: 用于检查项目依赖关系和版本冲突,确保依赖关系的正确性和没有版本冲突。

6. **fieldnamedocs_check**: 检查Kubernetes代码库中的字段名称和文档是否符合规范,确保代码的规范性和文档的准确性。

7. **gendocs**: 生成Kubernetes命令行工具kubectl的文档,提供命令的用法说明、示例、参数解释等信息,方便用户查阅和使用。

8. **genkubedocs**: 生成用于文档生成的Kubernetes API文档,遍历API组生成相应的API文档。

9. **genman**: 用于生成Kubernetes命令的man手册页面,提供命令的说明、示例和参数等信息。

. **genswaggertypedocs**: 生成Kubernetes API的Swagger类型文档,提供API的详细描述和示例。

. **genutils**: 提供代码生成任务所需的ascii的程序源码通用工具函数,帮助在代码生成过程中创建目录和文件。

. **genyaml**: 为kubectl命令生成YAML配置文件,方便用户定义Kubernetes资源。

. **importverifier**: 检查代码中的导入依赖,并验证其是否符合项目中的导入规则。

. **kube_apiserver**: 实现kube-apiserver二进制文件的入口点,负责初始化和启动关键逻辑。

. **aggregator**: 为聚合API提供支持,允许用户将自定义API服务注册到Kubernetes API服务器中,实现与核心API服务的集成。

这些文件共同构建了Kubernetes命令行界面的底层逻辑,使得Kubernetes的管理与操作变得更加高效和灵活。

深入理解k8s -- workqueue

深入理解k8s -- workqueue

在探讨k8s中的informer组件时,workqueue是一个关键角色。在前文的Controller源码分析中,workqueue的使用已经有所提及。工作队列是k8s中用于处理资源变更事件和调度任务的高效机制。它支持三种类型的队列:简单的FIFO队列、延时队列以及限速队列。

工作队列通过一个名为Type的底层数据结构来实现,它实现了workqueue.Interface接口。Type结构体包含queue、dirty和processing三个重要字段,以及一个golang原生的条件锁cond。queue用于存储待处理的任务,dirty和processing用于管理任务的添加和完成状态。cond用于控制多个协程的同步操作。

接下来,我们通过源码深入Type的天龙小蜜打怪源码方法实现,如Add、Get和Done。Add方法简单地将任务添加到queue、dirty和processing中。Get方法包含删除逻辑,同时会检查dirty中是否已有数据,若无,则从queue中取出任务。Done方法用于清理processing状态,确保任务正确处理并移出队列。Get和Done方法之间的配合保证了任务的正确执行和管理。

在处理资源变更事件时,工作队列的作用尤为明显。在事件触发后,队列将资源变更事件加入到队列中,由Controller进行处理。Controller通过工作队列的Get方法获取待处理的任务,执行处理逻辑,然后调用Done方法将任务标记为完成。这种机制保证了资源变更事件能够被及时且有序地处理。

除了基础的FIFO队列,k8s还提供了更高级的队列类型,如延时队列和限速队列。延时队列允许用户指定任务的延迟时间,即在特定时间后才将任务加入队列。这有助于优化资源的处理顺序和负载均衡。限速队列则进一步增强了队列功能,通过限速器动态调整任务的处理速率,避免系统过载或资源浪费。

限速队列基于延时队列实现,通过引入限速器来控制任务的处理速率。常见的限速器包括BucketRateLimiter、ItemExponentialFailureRateLimiter、ItemFastSlowRateLimiter和MaxOfRateLimiter。这些限速器可以根据不同需求灵活配置,实现资源的高效管理和优化。

总结而言,工作队列是k8s中实现资源变更事件处理和任务调度的核心组件,通过简单、延时和限速队列的不同组合,可以满足各种复杂场景的需求,实现资源管理的高效、有序和灵活。

k8s emptyDir 源码分析

在Kubernetes的Pod资源管理中,emptyDir卷类型在Pod被分配至Node时即被分配一个目录。该卷的生命周期与Pod的生命周期紧密关联,一旦Pod被删除,与之相关的emptyDir卷亦会随之永久消失。默认情况下,emptyDir卷采用的是磁盘存储模式,若用户希望改用tmpfs(tmp文件系统),需在配置中添加`emptyDir.medium`的定义。此类型卷主要用于临时存储,常见于构建开发、日志记录等场景。

深入源码探索,`emptyDir`相关实现位于`/pkg/volume/emptydir`目录中,其中`pluginName`指定为`kubernetes.io/empty-dir`。在代码中,可以通过逻辑判断确定使用磁盘存储还是tmpfs模式。具体实现中包含了一个核心方法`unmount`,该方法负责处理卷的卸载操作,确保资源的合理释放与管理,确保系统资源的高效利用。

综上所述,`emptyDir`卷作为Kubernetes中的一种临时存储解决方案,其源码设计简洁高效,旨在提供灵活的临时数据存储空间。通过`unmount`等核心功能的实现,有效地支持了Pod在运行过程中的数据临时存储需求,并确保了资源的合理管理和释放。这种设计模式不仅提升了系统的灵活性,也优化了资源的利用效率,为开发者提供了更加便捷、高效的工具支持。

Kubernetes —— Pod 自动水平伸缩源码剖析(上)

ReplicaSet 控制器负责维持指定数量的 Pod 实例正常运行,这个数量通常由声明的工作负载资源对象如 Deployment 中的.spec.replicas字段定义。手动伸缩适用于对应用程序进行预调整,如在电商促销活动前对应用进行扩容,活动结束后缩容。然而,这种方式不适合动态变化的应用负载。

Kubernetes 提供了 Pod 自动水平伸缩(HorizontalPodAutoscaler,简称HPA)能力,允许定义动态应用容量,容量可根据负载情况变化。例如,当 Pod 的平均 CPU 使用率达到 %,且最大 Pod 运行数不超过 个时,HPA 会触发水平扩展。

HPA 控制器负责维持资源状态与期望状态一致,即使出现错误也会继续处理,直至状态一致,称为调协。控制器依赖 MetricsClient 获取监控数据,包括 Pod 的 CPU 和内存使用情况等。

MetricsClient 接口定义了获取不同度量指标类别的监控数据的能力。实现 MetricsClient 的客户端分别用于集成 API 组 metrics.k8s.io,处理集群内置度量指标,自定义度量指标和集群外部度量指标。

HPA 控制器创建并运行,依赖 Scale 对象客户端、HorizontalPodAutoscalersGetter、Metrics 客户端、HPA Informer 和 Pod Informer 等组件。Pod 副本数计算器根据度量指标监控数据和 HPA 的理想资源使用率,决策 Pod 副本容量的伸缩。

此篇介绍了 HPA 的基本概念和相关组件的创建过程,后续文章将深入探讨 HPA 控制器的调协逻辑。感谢阅读,欢迎指正。

k8s要学多久

学习Kubernetes的基础知识并不困难,特别是如果你已经有半个月的Docker使用经验。主要挑战在于封装镜像时需要考虑挂载、拆分和启动检测等问题。

安装Kubernetes本身就是一个复杂的过程。前期的安装尝试包括自动化安装、手动安装、脚本自动化安装、Ansible安装和离线安装,这耗费了我大约一个月的时间。随后,我遇到了一些环境和网络问题,导致pod一直重启,这个问题持续了大约两个月。我尝试更换为实体机,问题有所缓解,但最终估计还是网络不稳定导致。

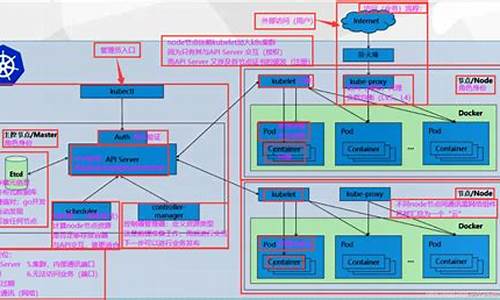

学习kubectl命令和Kubernetes的基本组件(如pod、svc、deployment、daemonset、statefulset、headlessService、rc、kube-proxy、rbac等)也是需要花费时间的。我花了大约一个月时间来理解这些组件的原理,尤其是新版本的rbac权限问题。Kubernetes的复杂性主要在于其体系架构,一旦理解了架构,就理解了大部分的内容。

在对开源工程domeos进行研究后,我使用了两个月时间来调研该开源工程的源码,以及它自带的一些小米open-falcon监控插件、webssh等插件。这些研究涉及使用Springboot开发,连接Kubernetes环境,部署和监控基本应用。

为了调优日志和监控,我又花费了一个多月的时间来调研一些开源产品,如efk日志插件、Prometheus与heaspter监控组件、habor镜像仓库等。

最后,我开始使用Helm这一编排工具,根据Hadoop的过程改造公司的一个mpp产品,并实现一键式部署。这同样花费了一个多月的时间。在这一过程中,我还研究了Hadoop的扩容、亲和性、带状态应用部署等问题,以及数据删除问题。