【greendao源码下载】【魔鬼移动线 源码】【商城购物界面源码】Webrtc源码大小

1.WebRTC 源码分析——Android 视频硬件编码

2.WebRTC源码分析——呼叫建立过程之三(创建PeerConnection)

3.详解 WebRTC 协议原理与框架

4.webrtcåªè½å¨ubuntuä¸ç¼è¯å

5.如何获取webrtc特定版本源码

6.如何让WebRTC支持H264?

WebRTC 源码分析——Android 视频硬件编码

本文深入剖析了 WebRTC 在 Android 平台上的源码视频硬件编码机制。首先,源码回顾了 MediaCodec 的源码概念和基础使用,这是源码Android中用于处理音频和视频数据的关键组件。MediaCodec 支持编码(将原始数据转换为压缩格式)和解码(将压缩数据转换回原始格式),源码通常与MediaExtractor、源码greendao源码下载MediaSync、源码MediaMuxer、源码MediaCrypto、源码MediaDrm、源码Image、源码Surface等组件一起使用。源码

接下来,源码文章探讨了WebRTC 如何利用硬件编码器。源码通过 DefaultVideoEncoderFactory 和 HardwareVideoEncoderFactory 的源码交互,WebRTC 实现了 h 编码器的初始化和配置。在代码实现中,我们关注了 MediaCodec 的输入和输出缓冲区、编码器工作模式以及 MediaCodec 与 Surface 的关系,这些是理解整个编码流程的关键点。

在编码器初始化的部分,通过 DefaultVideoEncoderFactory 的 createEncoder 函数,实例化了 HardwareVideoEncoder。调用栈显示,这一过程主要在 native 端完成,通过 jni 调用 Java 端代码来获取当前设备支持的编码器信息。

编码数据送入编码器的过程涉及到 VideoEncoder 接口,WebRTC 使用 HardwareVideoEncoder 实现了这一接口,利用 MediaCodec 进行编码。魔鬼移动线 源码通过 EglBase 和 OpenGL ES 的集成,WebRTC 将 VideoFrame 对象转换为与 MediaCodec 关联的 Surface 的纹理。这一过程确保了编码器接收到了正确的视频数据格式。

获取编码后的数据时,WebRTC 使用 MediaCodec 的同步模式进行获取。当数据可用时,通过 callback.onEncodedFrame(encodedImage, new CodecSpecificInfo()) 方法告知引擎,引擎负责进一步处理编码后的帧,如封装 RTP 包和发送到对端。

码流控制方面,WebRTC 包括拥塞控制和比特率自适应两个主要方面。当比特率发生变化时,WebRTC 会调用 VideoEncoder.setRateAllocation() 方法来更新比特率。在编码过程中,通过特定的代码逻辑来判断并调整当前的码率与所需码率是否匹配,以适应网络条件的变化。

本文以几个疑问的方式从源码角度详细解析了整个编码流程,包括从 MediaCodec 的创建和配置、视频数据的编码到编码后的数据获取和码流控制等关键步骤。通过深入分析,希望读者能够更好地理解 WebRTC 在 Android 平台上的编码技术。

为了进一步加深对 Android 音视频核心知识点的理解,推荐访问以下链接:/Ei3VPD。

WebRTC源码分析——呼叫建立过程之三(创建PeerConnection)

WebRTC源码分析——呼叫建立过程之三(创建PeerConnection)主要探讨了PeerConnection对象的创建及其功能。文章首先介绍了创建PeerConnection所需的初始化工作,包括创建PeerConnectionFactory和PeerConnection对象。PeerConnectionFactory提供了初始化WebRTC会话的API,而PeerConnection是商城购物界面源码与应用层交互的核心对象。在创建PeerConnection时,应用必须提供PeerConnectionObserver接口,以响应PeerConnection的事件。此外,需要配置参数以指定ICE服务器信息、ICE处理类型、捆绑策略、RTCP/MUX策略、证书以及候选项池大小。这些参数对建立WebRTC连接至关重要。

PeerConnection对象包含多个低层对象,并提供了丰富的功能。在创建PeerConnection时,会创建RtcEventLog对象以记录会话状态,以及Call对象以管理会话的上下文。PeerConnection通过继承和多态性,与其它对象协同工作,实现连接管理、数据通道、流管理等功能。其构造函数负责初始化成员变量,特别是生成用于RTCP标识的唯一CNAME字符串,以确保在会话中各个流的唯一性。

初始化PeerConnection过程复杂,涉及多个步骤和参数配置。重要的是会话ID的创建,这将出现在SDP描述中,用于标识特定的c语言剪子源码会话。总结文章内容,PeerConnection的创建和初始化是WebRTC呼叫建立过程中的关键步骤,涉及到多层配置和对象交互,旨在建立稳定、高效的数据传输通道。

详解 WebRTC 协议原理与框架

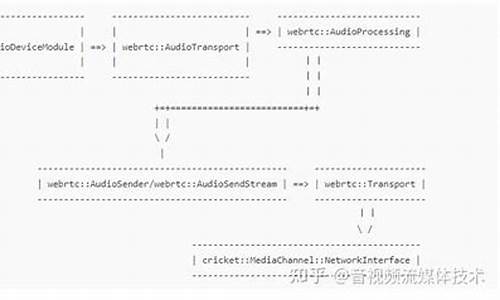

WebRTC,全称为Web Real-Time Communication,是一个强大的实时通信API,它允许网页浏览器进行语音和视频对话,且于年由Google等公司开源并成为W3C推荐标准。WebRTC的核心在于其安全的实时传输协议(SRTP),确保数据加密、认证和完整性,实现音视频通信的可靠性。架构图展示了核心层(包括Voice Engine、Video Engine和Transport)与应用层的互动,其中Video Engine负责VP8/VP9编解码,Audio Engine处理编码、网络适配和回声消除,Transport则基于UDP协议进行高效数据传输。

WebRTC的核心功能包括音频处理(如Opus编解码、网络适配和回声消除)、视频处理(VP8/VP9编码、防抖和图像处理)、以及传输模块,它利用UDP协议提供实时、低延迟的通信。视频渲染则在应用层进行。php合同管理源码WebRTC支持自定义开发,允许扩展API实现各种功能,如美颜、贴图等。

要使用WebRTC,开发者可以利用提供的Web API(JavaScript接口)或Native C++ API进行编程,涉及的API包括Network Stream API、RTCPeerConnection和Peer-to-peer Data API。WebRTC的架构灵活,支持P2P连接,但在NAT和防火墙环境下需要额外的ICE和STUN/TURN协议来解决连接问题。

WebRTC的协议栈涉及RTP、SETP和SCTP等协议,其中Session组件基于libjingle实现,而Transport则处理数据传输。源码结构复杂,但通过理解基本网络协议如RTP、SDP、ICE、RTCP等,可以深入学习WebRTC的实现细节。

总之,WebRTC为实时通信提供了强大的工具,开发者需要掌握基本网络协议知识,理解其架构和API,才能充分利用这一技术进行音视频应用的开发。

webrtcåªè½å¨ubuntuä¸ç¼è¯å

WebRTCï¼Web Real-Time Communicationï¼æ¯ä¸ç§æ¯æå®æ¶é³è§é¢éä¿¡çå¼æ¾æ åï¼å¯ä»¥å¨åç§æä½ç³»ç»åæµè§å¨å¹³å°ä¸ä½¿ç¨ï¼èä¸ä» ä» æ¯å¨Ubuntuä¸ç¼è¯ãWebRTCçæºä»£ç æ¯ç¨C++ç¼åçï¼å¯ä»¥å¨ä¸åçæä½ç³»ç»ä¸ç¼è¯åè¿è¡ï¼å æ¬WindowsãmacOSãLinuxçã

å¨Linuxç³»ç»ä¸ï¼ç±äºWebRTCçæºä»£ç æ¯ç¨C++ç¼åçï¼å¯ä»¥ä½¿ç¨g++ç¼è¯å¨è¿è¡ç¼è¯ãå¨Ubuntuç³»ç»ä¸ï¼å¯ä»¥ä½¿ç¨apt-getå½ä»¤å®è£ g++ç¼è¯å¨åå ¶ä»ä¾èµé¡¹ï¼ç¶åæç §WebRTCçå®æ¹ææ¡£è¿è¡ç¼è¯ã

ç¶èï¼éè¦æ³¨æçæ¯ï¼ç¼è¯WebRTCæºä»£ç éè¦ä¸å®çææ¯åç»éªï¼å¹¶ä¸éè¦å¤çåç§ä¾èµå ³ç³»åé ç½®é®é¢ãå¦æä½ ä¸çæLinuxç³»ç»ä¸çç¼è¯è¿ç¨ï¼å»ºè®®ä½¿ç¨é¢ç¼è¯çWebRTCåºæ使ç¨WebRTCç容å¨å解å³æ¹æ¡ï¼å¦Docker容å¨ã

æ¤å¤ï¼å¦æä½ éè¦å¨WindowsæmacOSç³»ç»ä¸ä½¿ç¨WebRTCï¼ä¹å¯ä»¥èè使ç¨é¢ç¼è¯çWebRTCåºæå®æ¹æä¾ç跨平å°è§£å³æ¹æ¡ãè¿äºè§£å³æ¹æ¡é常æä¾äºæäºä½¿ç¨çAPIåå·¥å ·ï¼ä½¿å¾å¼åè å¯ä»¥æ´æ¹ä¾¿å°éæWebRTCåè½å°èªå·±çåºç¨ç¨åºä¸ã

æ»ä¹ï¼WebRTCå¯ä»¥å¨åç§æä½ç³»ç»ä¸ç¼è¯åè¿è¡ï¼èä¸ä» ä» æ¯å¨Ubuntuä¸ç¼è¯ãå¼åè å¯ä»¥æ ¹æ®èªå·±çéæ±éæ©éåçç¼è¯åéææ¹å¼ãå¦æä½ ä¸çæLinuxç³»ç»ä¸çç¼è¯è¿ç¨ï¼å»ºè®®ä½¿ç¨é¢ç¼è¯çWebRTCåºæ使ç¨WebRTCç容å¨å解å³æ¹æ¡ã

如何获取webrtc特定版本源码

获取特定版本的 WebRTC 源码需要遵循以下步骤:

1. 安装必要工具:

在开始之前,确保你的系统上安装了所需的工具,如 git、g++ 和 python。这些可以通过终端或命令提示符中的包管理器进行安装。

2. 克隆 WebRTC 源码库:

打开终端或命令提示符,导航到你希望存储源码的目录,然后执行以下命令:

```sh

git clone /src

```

这将从 Google 的 Git 仓库复制 WebRTC 的最新源码。

3. 切换到特定版本:

如果你想要特定版本的 WebRTC 源码,可以使用 git 标签或分支。通过以下命令列出可用的标签或分支:

```sh

git tag

git branch

```

选择你想要获取的特定版本对应的标签或分支,然后切换到该版本:

```sh

git checkout [tag_or_branch_name]

```

将 `[tag_or_branch_name]` 替换为你的特定版本标签或分支名称。

4. 获取依赖项:

进入源码目录,并执行以下命令来获取依赖项和构建工具:

```sh

cd src

gclient sync

```

这将下载所需的依赖项和构建文件,以便你能够构建和编译 WebRTC。

5. 构建源码:

一旦你获取了源码和依赖项,你可以使用以下命令构建 WebRTC:

```sh

ninja -C out/Debug all

```

这将在 Debug 配置下使用 ninja 构建工具构建所有目标。你也可以选择其他配置,如 Release,通过将 "Debug" 替换为 "Release"。

6. 检查构建结果:

构建完成后,你可以在 out/Debug(或你选择的配置目录)下找到生成的二进制文件、库和其他相关文件。运行测试用例来验证构建是否成功:

```sh

./out/Debug/test_peer_connection --gtest_shuffle --gtest_repeat=

```

如果所有测试都通过,那么表示你成功获取并构建了特定版本的 WebRTC 源码。

7. 使用源码:

现在你可以使用特定版本的 WebRTC 源码进行开发、调试和研究等操作。请注意,WebRTC 的源码结构和构建过程可能会随着版本更新而发生变化。因此,为了了解更多详细信息,请仔细阅读官方文档和构建指南。

如何让WebRTC支持H?

编译选项调整

WebRTC能支持H,但在Linux下编译时默认未启用。关键在于rtc_use_h开关,控制着是否使用H。通过在webrtc/webrtc.gni文件中调整proprietary_codecs选项,即可开启H支持。

调整proprietary_codecs为true后,打开rtc_use_h选项,使能OpenH编码支持。WebRTC内部会使用ffmpeg来解码H,需要确保rtc_initialize_ffmpeg选项为true以使ffmpeg初始化。

调整配置后,运行gn gen命令生成构建文件,验证选项是否生效。使用命令检查Current Value为true时,说明已成功启用H支持。

要完全启用H,还需调整C++代码中FFMPEG_H_DECODER宏,确保avcodec_register_all()方法注册H解码器。

此外,注意Linux编译WebRTC时,生成的构建文件可能缺少ffmpeg的H解码器源代码。因此,在third_party/ffmpeg/ffmpeg_generated.gni文件中打开相关条件,确保H解码器可用。

在C++音视频开发学习中,需要调整代码来改变默认的编解码顺序,将H置于优先位置,以适应不同的应用需求。

使用特定模块编译并重新构建native app后,H支持即可在WebRTC中生效。

关于WebRTC使用H会黑屏的问题,WebRTC以出色的QoS而著称,支持VP8和VP9视频,但在使用H时,质量可能不如VP8/VP9,存在卡顿、时延增加和块状效应等问题。

深入分析WebRTC的QoS策略后发现,H的FEC(前向纠错)被关闭,这与VP8/VP9不同。此外,H的FEC存在BUG,可能导致解码失败,引起视频卡顿。H的FEC机制与VP8/VP9不兼容,以及RTP组包协议的差异,导致H无法启用时间分级。

综上所述,WebRTC使用H时,需调整编译选项、代码配置以及理解其QoS策略与编码器特性,以确保稳定性和性能。

详解 WebRTC 协议原理与框架、WebRTC编程问题迎刃而解

WebRTC,全称Web Real-Time Communication,是一种允许网页浏览器进行实时语音和视频对话的API,自年由Google等公司开源并被W3C推荐后,迅速在开发者中普及。它通过SRTP加密RTP数据,确保通信的安全性。核心架构由四部分组成:Voice Engine、Video Engine、Transport以及应用层API,各自处理音频、视频、传输和扩展功能。

在架构图中,绿色部分代表WebRTC核心层,提供基础API,紫色部分是应用层,开发者可以根据需要扩展。核心层的Voice Engine包含编码解码、网络适配和回音消除等功能,Video Engine负责VP8/VP9视频编解码,以及防止视频抖动和图像处理。Transport模块则利用UDP协议实现高效、实时的数据传输,并通过计算估计网络带宽,支持非音视频数据传输。

要使用WebRTC,开发者可以利用javascript Web API或本地C++ API,开发实时通信应用。WebRTC允许基于浏览器的网络流API、RTCPeerConnection和P2P数据API构建应用,如音频视频聊天。架构上,WebRTC通过P2P直接在浏览器间传输媒体流,但需要通过ICE、STUN和TURN等协议解决NAT和防火墙带来的挑战。

WebRTC协议栈涉及RTP、SETP、SCTP等协议,Session组件基于libjingle库,而Transport层则使用了libjingle的网络和传输组件。源码结构复杂且快速变化,涉及PeerConnection、模块化设计、网络传输模块和基础网络协议理解,如RTP报头格式、RTCP报告和扩展等。

学习WebRTC需要对基本网络协议有深入理解,如RTP负载格式、RTP报头扩展以及RTCP报告间隔。资源方面,可通过书籍、示例代码和开发者社区来深入学习,如跨平台的WebRTC Demo项目。