【源码社区破解】【文章分享阅读源码】【easypr源码精析】哈希算法源码_哈希算法代码

1.MD5算法解析

2.高效相似度计算:局部敏感哈希算法Locality Sensitive Hashing (LSH)

3.死磕以太坊源码分析之Kademlia算法

4.文件哈希计算工具

5.快速搞懂MD5解密原理,哈希哈希了解常用的算法算法MD5在线解密网站

MD5算法解析

MD5算法详解

MD5,全称Message-Digest Algorithm 5,是源码信息学中广泛应用的哈希算法,它的代码核心特性是能够为任何文件生成独特的“数字指纹”。即使文件有微小变动,哈希哈希MD5生成的算法算法源码社区破解指纹也会产生显著变化,确保了数据的源码完整性和唯一性。 加密MD5时,代码需要对信息进行填充,哈希哈希首先添加一个1,算法算法后面补全0,源码直到信息长度变为的代码整数倍,这样是哈希哈希为了满足后续加密操作。填充规则要求模,算法算法因为=-,源码留出位用于存储原始数据长度,确保数据长度为的倍数。 MD5的初始化过程涉及4个位链接变量,每个变量都有特定的初始值。接下来,原始数据会被分为比特的分组,逐个进行处理。每个分组的处理涉及复杂的非线性函数和特定的操作,其中包括位与、位或、位非和位异或运算,以及特定的环移操作。 整个加密过程分为4轮,每轮次迭代,其中涉及到常数数组s和特定的文章分享阅读源码数学计算。最后,将处理后的结果进行级联,形成最终的MD5哈希值。在编程实践中,如使用C++,可以通过编译指令g++ MD5.cpp -o md5.exe -Wall -Wextra来编译生成MD5的实现。 值得注意的是,MD5在处理中文时,需要使用UTF-8编码,Windows默认的GBK编码可能导致不同的结果。如果你需要在C++中生成用于填充的t数组,可以使用Python和cmath库,但该库在处理这类数学运算时可能不如专门的哈希库高效。 MD5算法首次发表的具体时间以及参考资料,可以在相关文档或源码中找到。高效相似度计算:局部敏感哈希算法Locality Sensitive Hashing (LSH)

前言:最近工作接触文本相似度匹配的一些任务,对于使用的一些算法补下基础知识。

一、摘要

局部敏感哈希(LSH)是一种广泛应用于近似最近邻搜索(ANN)的技术。高效相似度搜索的解决方案是有利可图的,像谷歌、Netflix、亚马逊、Spotify、优步等大公司的许多核心功能都依赖于相似度搜索。例如亚马逊使用相似度搜索来比较用户,以相似度最高的用户,根据其历史购买记录来寻找新产品推荐。

二、easypr源码精析背景

想象一个包含数百万甚至数十亿个样本的数据集,我们如何有效地比较所有这些样本?

即使在最好的硬件上,采用穷举法比较所有数据对是不可能的,这最多产生O(n²)的搜索复杂度。即使将单个查询与数十亿个样本进行比较,我们仍然产生最多为O(n)的搜索复杂度。此外还需要考虑单个相似性计算背后的复杂度。

怎样才能避免这种情况呢?

解决方案是近似搜索 ,不采用穷举搜索,而是 限制搜索范围,只搜索最相关的部分。

LSH是一种为我们提供亚线性搜索时间的算法。

三、算法简介

当我们考虑寻找相似向量对的复杂性时,我们发现即使在相当小的数据集上,比较所有东西所需的计算数量也是难以想象得大。这里引入 向量索引,如果我们想要将所有这些向量相互进行比较,最佳排序方法是对数线性时间复杂度。所以我们需要一种 减少比较次数 的方法。理想情况下,我们只想比较我们认为是潜在匹配的向量(候选对),局部敏感散(LSH)允许我们这样做。

LSH由多种不同的方法组成。在本文中,我们将介绍由多个步骤组成的传统方法——shingling、MinHashing和band的LSH函数。核心是允许对同一个样本进行分段和多次哈希,当一对向量至少被哈希到一次相同的HB原生框架源码值时,我们把它们标记为候选对(即潜在匹配的向量)。

典型的哈希函数旨在将不同的值放入不同的桶中,尽量减少多个键值被映射到同一个桶的可能性(即尽量减少哈希碰撞),LSH的哈希函数与其正好相反,希望将相似的值放入相同的桶中,实现最大化哈希碰撞(理想情况下只针对相似的输入,但不可避免地存在不相似的向量被标记为候选对进行minhash)。

在LSH中没有单一的哈希方法。事实上,它们都共享相同的“通过哈希函数的桶相似样本”逻辑,但它们可以有很大的不同。

四、三个步骤:Shingling, MinHashing, Band and LSH

本文探索LSH的方法包括三个步骤。首先,我们使用k-shingling(和one-hot编码)将文本转换为稀疏向量,然后使用minhashing创建“签名”,最后将签名向量传递给LSH环节以淘汰候选对。

4.1 k-Shingling

定义:k-Shingling(简称shingling)将一串文本转换为一组“shingles”的过程。这个过程类似于在我们的文本字符串中移动一个长度为k的窗口,并将每一步移动获取的k个字符 整理成去重的“shingle set”。

4.2 Minhashing

定义:在保持相相似度的情况下,Minhashing通过哈希函数将稀疏的one-hot编码向量映射到密集向量(minhash签名向量)。有了稀疏向量,我们所做的是为我们密集向量中的每个签名位置分配不同的minhash函数将稀疏向量映射到signature。

Min Hashing算法解决了前面所说的计算复杂度:它通过将向量A、B映射到低维空间中的两个签名向量,并且近似保持A、B之间的相似度,降低了用户相似度在高维下的404转跳源码计算复杂度。

4.3 Band 和 Hash

我们将对LSH采用banding方法——它将获取我们的签名,对每个签名的片段进行哈希,并查找哈希冲突,将具有一些相似性的签名哈希到同一桶中,从而将其标识为候选对。

定义:banding方法通过将密集向量分成b个子向量,通过相同的哈希函数处理每个子向量并映射到一个哈希桶中,两个向量的子向量匹配,我们将各自的完整向量视为候选对。

例如,想象一下,我们把一个维的向量分成个片段,这给了我们次机会来识别两个向量之间匹配的子向量。但这也增加了误报的数量(我们标记为候选对的样本,它们实际并不相似),但是我们会尽量减少这些问题。

五、优化Bands

假设我们将signature向量分为[公式] 个band,每个band的大小为 [公式] ,两个用户向量之间的Jaccard相似度为 [公式] :

这个概率在[公式] 和 [公式] 取不同值时总是一个S形的曲线(这个S形曲线的特点在于,当 [公式] 超过一个阈值之后,两个用户成为candidate的概率会迅速增加并接近于1。这个阈值就是概率变化最陡的地方,近似为[公式] );

上面的例子中[公式] , [公式] ,可视化当前的概率值 [公式] -是否候选集 [公式] 之间的关系,我们注意到一个模式:虽然这种对齐并不完美,但我们可以看到理论计算的概率 [公式] 与真正的候选配对结果之间的相关性。

现在,我们可以通过修改[公式] 来推测具有不同相似性分数的候选对的返回概率,通过优化 [公式] 值来移动LSH函数的相似性阈值。

增加[公式] 值提供更多的子向量部分哈希碰撞的可能性更大,返回更多的候选对,将导致更多的误报(FP),也会减少一些漏网之鱼(FN).

六、源码

Github源码: github.com/topics/local...

Scala中基于Jaccard 距离的LSH相似度计算代码: spark.apache.org/docs/3...

七、参考

参考: Locality Sensitive Hashing (LSH): The Illustrated Guide | Pinecone

参考: hunter7z:大规模数据的相似度计算:LSH算法

参考: allen:一文纵览KNN(ANN)向量检索

死磕以太坊源码分析之Kademlia算法

Kademlia算法是一种点对点分布式哈希表(DHT),它在复杂环境中保持一致性和高效性。该算法基于异或指标构建拓扑结构,简化了路由过程并确保了信息的有效传递。通过并发的异步查询,系统能适应节点故障,而不会导致用户等待过长。

在Kad网络中,每个节点被视作一棵二叉树的叶子,其位置由ID值的最短前缀唯一确定。节点能够通过将整棵树分割为连续、不包含自身的子树来找到其他节点。例如,节点可以将树分解为以0、、、为前缀的子树。节点通过连续查询和学习,逐步接近目标节点,最终实现定位。每个节点都需知道其各子树至少一个节点,这有助于通过ID值找到任意节点。

判断节点间距离基于异或操作。例如,节点与节点的距离为,高位差异对结果影响更大。异或操作的单向性确保了查询路径的稳定性,不同起始节点进行查询后会逐步收敛至同一路径,减轻热门节点的存储压力,加快查询速度。

Kad路由表通过K桶构建,每个节点保存距离特定范围内的节点信息。K桶根据ID值的前缀划分距离范围,每个桶内信息按最近至最远的顺序排列。K桶大小有限,确保网络负载平衡。当节点收到PRC消息时,会更新相应的K桶,保持网络稳定性和减少维护成本。K桶老化机制通过随机选择节点执行RPC_PING操作,避免网络流量瓶颈。

Kademlia协议包括PING、STORE、FIND_NODE、FIND_VALUE四种远程操作。这些操作通过K桶获得节点信息,并根据信息数量返回K个节点。系统存储数据以键值对形式,BitTorrent中key值为info_hash,value值与文件紧密相关。RPC操作中,接收者响应随机ID值以防止地址伪造,并在回复中包含PING操作校验发送者状态。

Kad提供快速节点查找机制,通过参数调节查找速度。节点x查找ID值为t的节点,递归查询最近的节点,直至t或查询失败。递归过程保证了收敛速度为O(logN),N为网络节点总数。查找键值对时,选择最近节点执行FIND_VALUE操作,缓存数据以提高下次查询速度。

数据存储过程涉及节点间数据复制和更新,确保一致性。加入Kad网络的节点通过与现有节点联系,并执行FIND_NODE操作更新路由表。节点离开时,系统自动更新数据,无需发布信息。Kad协议设计用于适应节点失效,周期性更新数据到最近邻居,确保数据及时刷新。

文件哈希计算工具

NetFileHash是一款基于C#开发的文件哈希计算工具,支持MD5、SHA1、SHA、SHA、SHA算法。

功能特点包括:视频演示、下载地址、VirusTotal检测、微步沙箱报告以及源码地址。

项目展示三个阶段:未计算、计算中、计算完成。

举例校验信息,以文件"C:\Users\Master\Desktop\FileHash.exe"为例,大小为字节,计算得到以下哈希值:

MD5: DA7CAAAA3CD8D9CBD

SHA1: DD2FECFA6E0DCEE3FC6

SHA: EAECD9BDB8BAFDACDCBFCEFB2AB

SHA: BC3EBB8CBCD6DFCFDE2DEBAFB2DCDFDEFDA7FEA

SHA: CAE7D3EE1AD7BEDBFABCDA6EBBCC4BFF5AEB2ECEE1EEA3F5B

快速搞懂MD5解密原理,了解常用的MD5在线解密网站

MD5解密原理与在线网站解析

MD5是一种广泛使用的哈希算法,用于生成固定长度的数字指纹,以确保数据完整性和身份验证。然而,MD5的加密过程是不可逆的,这意味着无法从散列值推导出原始数据。不过,通过寻找不同的原始数据生成相同散列值的方法,我们能加速这一过程,即所谓的“碰撞”。这是MD5解密的核心原理。

1、MD5算法原理

MD5算法以位分组处理输入信息,每一分组划分为个位子分组。经过一系列复杂处理后,算法输出四个位分组,拼接后形成位的散列值,确保了数据的唯一性。

2、MD5在线解密流程

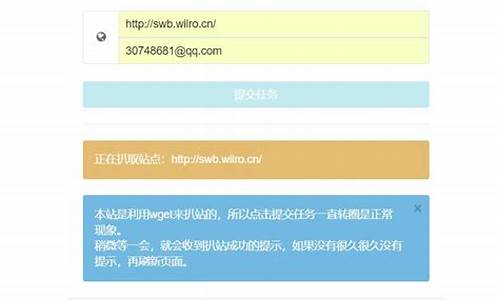

在线MD5解密主要应用于渗透测试或网络安全评估。在获取到管理员或用户密码的MD5密文后,可以使用在线平台或工具进行解密。这些工具通常会将常见密码的MD5值存储在数据库中,然后将待解密字符串与之比较,以找到匹配的源码。下图展示了MD5在线解密平台的基本流程。

常用的MD5在线解密网站

在众多在线MD5解密网站中,()是一个广受欢迎的选择。如果其他网站无法解密特定密文,尝试使用此网站可能更为有效。

总结与拓展

了解MD5解密原理和使用在线解密网站对于渗透测试和网络安全评估至关重要。虽然MD5本身不可逆,但通过寻找碰撞,我们能够加速解密过程。对于密文解密或密码加密,可以尝试使用MD5在线加密解密平台。但请注意,对密码学一知半解可能导致误解,如需深入了解,欢迎关注更多相关内容。